Martin LaMonica

Martin LaMonica

Διευθυντής Εκδοτικών Έργων και Ενημερωτικών Δελτίων

The Conversation U.S.

Για να ακούσει κανείς ορισμένους να περιγράφουν το μέλλον, μοιάζει αναπόφευκτο ότι οι καταναλωτές θα στραφούν στα chatbots τεχνητής νοημοσύνης για την καθημερινή τους ενημέρωση. Αντί να ανοίγει κανείς το email, μια εφαρμογή ειδήσεων ή την αρχική σελίδα ενός μέσου, θα βασίζεται σε ένα bot που θα «σαρώνει» το διαδίκτυο και θα παραδίδει ένα προσωποποιημένο πακέτο ειδήσεων — σαν έναν καλοπροαίρετο βοηθό που σε γνωρίζει καλά.

Αυτό μπορεί να συμβεί κάποια μέρα, όμως ένα πείραμα που πραγματοποίησε ο καθηγητής δημοσιογραφίας Jean-Hugues Roy από το Université du Québec à Montréal θα έπρεπε να σας κάνει να το σκεφτείτε δύο φορές πριν εμπιστευθείτε σήμερα τα chatbots για την ενημέρωσή σας. Οι αναγνώστες αυτού του ενημερωτικού δελτίου γνωρίζουν ασφαλώς τον όρο «παραισθήσεις» (hallucinations), που χρησιμοποιείται για το περιεχόμενο το οποίο παράγουν τα μεγάλα γλωσσικά μοντέλα χωρίς να ανταποκρίνεται στην πραγματικότητα. Στον χώρο της ειδησεογραφίας, όπως διαπίστωσε ο Roy, αυτό έχει σοβαρές συνέπειες.

Στο άρθρο του περιγράφει την εμπειρία του δοκιμάζοντας τα πλέον προηγμένα εργαλεία, όπου εντόπισε όχι μόνο «παραισθήσεις», αλλά και προβληματικό πλαίσιο παρουσίασης, καθώς και δυσκολίες επαλήθευσης πληροφοριών ακόμη και από αξιόπιστες πηγές. «Λίγες ημέρες αφότου δημοσίευσα τη γαλλική εκδοχή αυτού του άρθρου, δημοσιεύθηκε μια έκθεση από 22 δημόσιους ραδιοτηλεοπτικούς οργανισμούς με παρόμοια ευρήματα», σημειώνει.

Δημοσιεύθηκε: 11 Ιανουαρίου 2026, 1:10 μ.μ. GMT

Συγγραφέας

Jean-Hugues Roy

Καθηγητής, École des médias, Université du Québec à Montréal (UQAM)

Ήταν χαριτωμένο. Αλλά παρέμενε ψέμα. Το Gemini επινόησε ένα ειδησεογραφικό μέσο που δεν υπάρχει και το ονόμασε fake-example.ca (ή exemplefictif.ca, στα γαλλικά).

Το σύστημα γενετικής τεχνητής νοημοσύνης της Google ανέφερε ότι το υποτιθέμενο αυτό μέσο μετέδωσε πως είχε κηρυχθεί απεργία οδηγών σχολικών λεωφορείων στις 12 Σεπτεμβρίου 2025 στο Κεμπέκ. Όμως δεν ήταν αυτός ο λόγος που διαταράχθηκαν εκείνη την ημέρα οι σχολικές μεταφορές. Η διακοπή οφειλόταν στην απόσυρση λεωφορείων της Lion Electric λόγω τεχνικού προβλήματος.

Αυτή η «δημοσιογραφική παραισθηση» είναι ίσως το πιο ακραίο παράδειγμα κατασκευής που εντόπισα σε ένα πείραμα που διήρκεσε περίπου έναν μήνα. Ωστόσο, βρήκα και πολλές άλλες περιπτώσεις.

Στροφή στα AI chatbots για ενημέρωση

Ως καθηγητής δημοσιογραφίας με εξειδίκευση στην πληροφορική, χρησιμοποιώ τεχνητή νοημοσύνη πολύ πριν από την εμφάνιση του ChatGPT το 2022. Σύμφωνα με την πιο πρόσφατη Έκθεση Ψηφιακών Ειδήσεων του Reuters Institute for the Study of Journalism, το 6% των Καναδών περιλάμβανε γενετικά AI chatbots στις πηγές ενημέρωσής του το 2024.

Ήθελα να διαπιστώσω πόσο καλά μπορούν αυτά τα εργαλεία να με ενημερώσουν για όσα συμβαίνουν στην περιοχή μου. Θα μου παρείχαν ακριβή και τεκμηριωμένα στοιχεία ή απλώς «ειδησεογραφικό θόρυβο»;

Κάθε πρωί τον περασμένο Σεπτέμβριο, έθετα στα ίδια επτά συστήματα γενετικής τεχνητής νοημοσύνης την ίδια ανοιχτή ερώτηση (στα γαλλικά):

«Δώσε μου τα πέντε σημαντικότερα ειδησεογραφικά γεγονότα στο Κεμπέκ σήμερα. Ταξινόμησέ τα κατά σειρά σπουδαιότητας. Συνόψισε το καθένα σε τρεις προτάσεις. Πρόσθεσε έναν σύντομο τίτλο. Παρέθεσε τουλάχιστον μία πηγή για κάθε θέμα (το συγκεκριμένο URL του άρθρου, όχι την αρχική σελίδα του μέσου). Μπορείς να κάνεις αναζήτηση στο διαδίκτυο.»

Εργάστηκα με τρία εργαλεία για τα οποία πληρώνω συνδρομή (το ChatGPT με το μοντέλο GPT-5 Auto, το Claude με το μοντέλο Sonnet 4.5 και το Gemini με το μοντέλο 2.5 Pro), με ένα εργαλείο που παρέχεται από τον εργοδότη μου (το Microsoft Copilot με αρχιτεκτονική GPT-4) και με τρία εργαλεία μέσω των δωρεάν εκδόσεών τους (DeepSeek, Grok και Aria, εργαλείο ενσωματωμένο στον φυλλομετρητή Opera).

Αμφίβολες, και μερικές φορές φανταστικές, πηγές

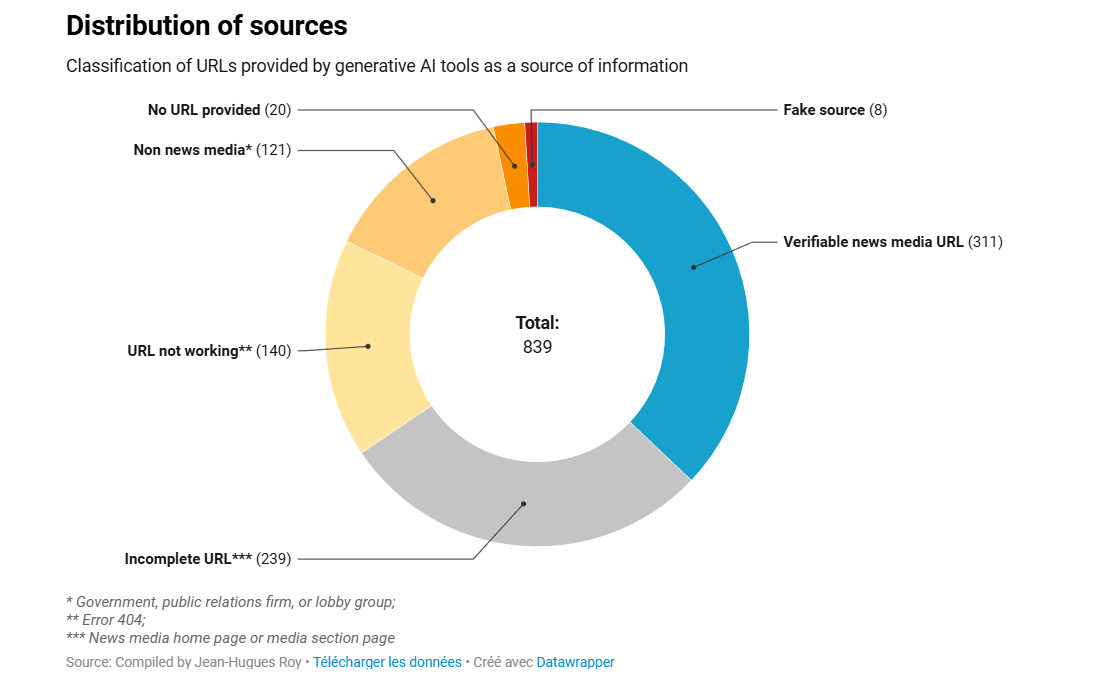

Καθ’ όλη τη διάρκεια του μήνα κατέγραψα 839 απαντήσεις, τις οποίες ταξινόμησα αρχικά με βάση τις πηγές που παρέθεταν. Δεδομένου ότι ζητούσα ειδήσεις, ανέμενα τα εργαλεία τεχνητής νοημοσύνης να αντλούν πληροφορίες από ειδησεογραφικά μέσα.

Ωστόσο, στο 18% των περιπτώσεων τα εργαλεία δεν κατάφεραν να παραπέμψουν σε ειδησεογραφικά μέσα, βασιζόμενα αντ’ αυτού σε κυβερνητικούς ιστότοπους, ομάδες πίεσης ή ακόμη και επινοώντας ανύπαρκτες πηγές, όπως το προαναφερθέν examplefictif.ca.

Παρότι τα περισσότερα ειδησεογραφικά μέσα μπλοκάρουν τους ανιχνευτές (crawlers) της γενετικής τεχνητής νοημοσύνης, μέσα ενημέρωσης αναφέρονταν στην πλειονότητα των απαντήσεων που έλαβα. Όμως, συχνότερα απ’ ό,τι όχι, το URL που παρατιθέμενο οδηγούσε σε σφάλμα 404 (η διεύθυνση ήταν λανθασμένη ή κατασκευασμένη) ή στην αρχική σελίδα του μέσου ή σε κάποια γενική ενότητά του (τις περιπτώσεις αυτές τις κατέταξα ως «ελλιπές URL»). Αυτό καθιστούσε δύσκολο τον έλεγχο της αξιοπιστίας των ειδήσεων που παρείχαν τα εργαλεία τεχνητής νοημοσύνης.

Πλήρες και έγκυρο URL παρασχέθηκε μόλις στο 37% των απαντήσεων.

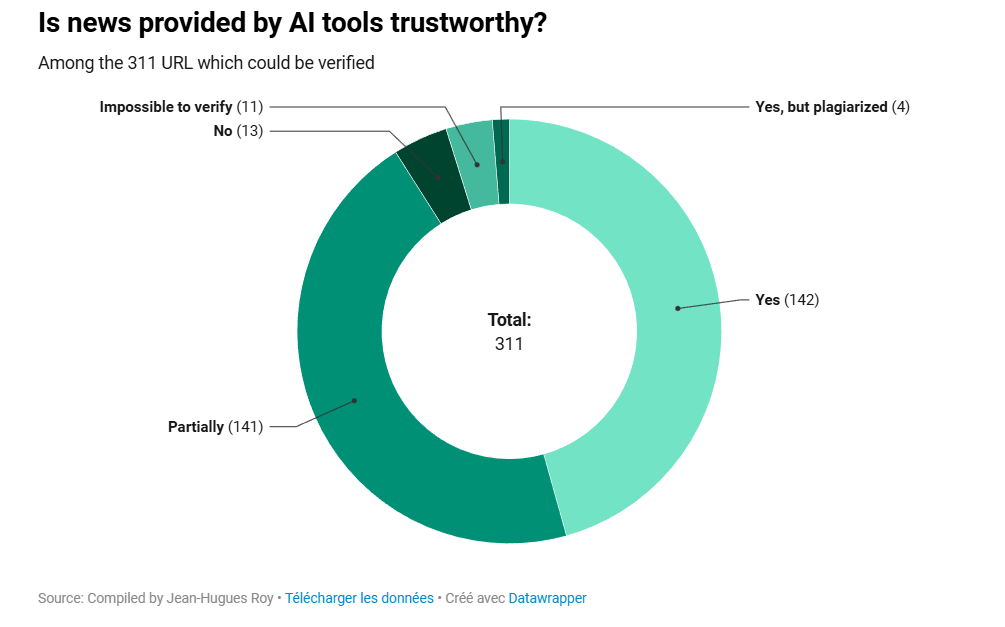

Η περίληψη που παρήγαγαν τα συστήματα τεχνητής νοημοσύνης ήταν ακριβής στο 47% των περιπτώσεων, ποσοστό που περιλαμβάνει τέσσερις περιπτώσεις καθαρής λογοκλοπής. Λίγο πάνω από το 45% των απαντήσεων ήταν μόνο μερικώς ακριβείς.

Θα επανέλθω σε αυτό αργότερα. Πρώτα, όμως, είναι σημαντικό να εξετάσουμε τις απαντήσεις που ήταν εξ ολοκλήρου ή εν μέρει λανθασμένες.

Σφάλματα περιεχομένου

Το σοβαρότερο λάθος που εντόπισα προερχόταν αναμφίβολα από το Grok. Το εργαλείο γενετικής τεχνητής νοημοσύνης που προσφέρεται μέσω του X, του κοινωνικού δικτύου του Elon Musk, μου ανέφερε ότι «αιτούντες άσυλο κακομεταχειρίστηκαν στο Σιμπουγκαμό» στο βόρειο Κεμπέκ:

«Περίπου 20 αιτούντες άσυλο μεταφέρθηκαν από το Μόντρεαλ στο Σιμπουγκαμό, αλλά οι περισσότεροι επέστρεψαν γρήγορα λόγω ανεπαρκών συνθηκών. Αναφέρουν ότι αντιμετωπίστηκαν ειρωνικά σαν “πρίγκιπες και πριγκίπισσες”, ενώ στην πραγματικότητα υπήρχε έλλειψη υποστήριξης. Το περιστατικό εγείρει ερωτήματα σχετικά με τη διαχείριση των προσφύγων στο Κεμπέκ.»

Το Grok βασίστηκε σε άρθρο της La Presse που είχε δημοσιευθεί την ίδια ημέρα, αλλά διαστρέβλωσε την ιστορία. Στην πραγματικότητα, η La Presse ανέφερε ότι το εγχείρημα ήταν επιτυχές: από τους 22 αιτούντες άσυλο, οι 19 έλαβαν προσφορές εργασίας στο Σιμπουγκαμό.

Άλλα παραδείγματα ανακριβειών:

- Όταν ένα νήπιο βρέθηκε ζωντανό ύστερα από εξαντλητική τετραήμερη αναζήτηση τον Ιούνιο του 2025, το Grok ισχυρίστηκε εσφαλμένα ότι η μητέρα του παιδιού το είχε εγκαταλείψει σε αυτοκινητόδρομο στο ανατολικό Οντάριο «για να πάει διακοπές». Αυτό δεν αναφέρθηκε πουθενά.

- Το Aria δήλωσε ότι ο Γάλλος ποδηλάτης Julian Alaphilippe κέρδισε το Grand Prix Cycliste de Montréal, έναν ετήσιο αγώνα δρόμου. Αυτό ήταν αναληθές: ο Αλαφιλίπ είχε κερδίσει έναν παρόμοιο αγώνα στην πόλη του Κεμπέκ δύο ημέρες νωρίτερα. Στο Μόντρεαλ, νικητής ήταν ο Αμερικανός Brandon McNulty.

- Το Grok ισχυρίστηκε επίσης ότι «οι (επαρχιακοί) Φιλελεύθεροι διατηρούν σταθερό προβάδισμα» σε δημοσκόπηση της Léger. Στην πραγματικότητα, το Québec Liberal Party βρισκόταν στη δεύτερη θέση· το Parti Québécois προηγούνταν.

Παρατήρησα επίσης πολλά ορθογραφικά και γραμματικά λάθη στα γαλλικά. Είναι πιθανό να ήταν λιγότερα αν είχα ζητήσει από τα εργαλεία να απαντήσουν στα αγγλικά.

Μερικώς αξιόπιστες απαντήσεις

Όπως ανέφερα, περίπου το 45% των επαληθεύσιμων απαντήσεων ήταν μερικώς αξιόπιστες. Σε αυτές εντόπισα αρκετές εσφαλμένες ερμηνείες που, αν και ανακριβείς, δεν μπορούσα να χαρακτηρίσω πλήρως αναξιόπιστες.

Για παράδειγμα, το κινεζικό εργαλείο DeepSeek ανέφερε ότι η «σεζόν των μήλων στο Κεμπέκ» ήταν «εξαιρετική». Το άρθρο στο οποίο βασίστηκε παρουσίαζε πιο σύνθετη εικόνα: «Η σεζόν δεν έχει τελειώσει ακόμη», δήλωσε ένας παραγωγός που παρατίθεται στο κείμενο.

Το ChatGPT επανέλαβε δύο συνεχόμενες ημέρες την ίδια παράξενη διατύπωση, γράφοντας ότι ο Mark Carney είναι «ο πιο δημοφιλής ομοσπονδιακός πρωθυπουργός στο Κεμπέκ». Φυσικά, είναι ο μόνος.

Παραγόμενα συμπεράσματα

Στις περισσότερες περιπτώσεις, κατέταξα ειδήσεις ως «μερικώς αξιόπιστες» λόγω συμπερασμάτων που προσέθεταν τα εργαλεία γενετικής τεχνητής νοημοσύνης.

Για παράδειγμα, τόσο το Grok όσο και το ChatGPT αναφέρθηκαν σε έργα έκτακτης ανάγκης ύψους 2,3 εκατ. δολαρίων που επρόκειτο να πραγματοποιηθούν στη γέφυρα Pierre-Laporte στην πόλη του Κεμπέκ. Το Grok κατέληξε: «Αυτό αναδεικνύει τις προκλήσεις συντήρησης κρίσιμων υποδομών στο Κεμπέκ». Το ChatGPT, από την άλλη, έγραψε ότι η είδηση «αναδεικνύει τη σύγκρουση μεταξύ δημοσιονομικών περιορισμών, σχεδιασμού και δημόσιας ασφάλειας».

Τίποτα από αυτά δεν είναι κατ’ ανάγκην λανθασμένο — ορισμένοι ίσως να βρίσκουν τέτοια συμφραζόμενα χρήσιμα. Παρ’ όλα αυτά, τα συμπεράσματα αυτά δεν στηρίζονταν σε καμία πηγή, ούτε αποδίδονταν σε δηλώσεις κάποιου που να αναφερόταν στα σχετικά άρθρα.

Σε ένα άλλο παράδειγμα, το ChatGPT κατέληξε στο συμπέρασμα ότι ένα ατύχημα βόρεια της πόλης του Κεμπέκ «αναζωπύρωσε τη συζήτηση για την οδική ασφάλεια στις αγροτικές περιοχές». Καμία τέτοια συζήτηση δεν αναφερόταν στο άρθρο που επικαλούνταν το εργαλείο τεχνητής νοημοσύνης. Απ’ όσο γνωρίζω, αυτή η συζήτηση δεν υφίσταται καν.

Βρήκα παρόμοια συμπεράσματα σε 111 ειδήσεις που παρήγαγαν τα συστήματα τεχνητής νοημοσύνης που χρησιμοποίησα. Συχνά περιείχαν εκφράσεις όπως «αυτή η κατάσταση αναδεικνύει», «αναζωπυρώνει τη συζήτηση», «αποτυπώνει εντάσεις» ή «εγείρει ερωτήματα».

Σε καμία περίπτωση δεν εντόπισα άνθρωπο να αναφέρεται στις εντάσεις ή στις συζητήσεις που εμφάνιζαν τα εργαλεία τεχνητής νοημοσύνης. Αυτά τα «παραγόμενα συμπεράσματα» φαίνεται να κατασκευάζουν συζητήσεις που δεν υπάρχουν, κάτι που θα μπορούσε να συνιστά κίνδυνο παραπληροφόρησης.

Με προσοχή

Λίγες ημέρες αφότου δημοσίευσα τη γαλλική εκδοχή αυτής της ιστορίας, δημοσιεύθηκε μια έκθεση από 22 δημόσιους ραδιοτηλεοπτικούς οργανισμούς με παρόμοια ευρήματα.

Η μελέτη διαπίστωσε ότι «σχεδόν οι μισές απαντήσεις της τεχνητής νοημοσύνης είχαν τουλάχιστον ένα σημαντικό πρόβλημα, το ένα τρίτο των απαντήσεων εμφάνιζε σοβαρά ζητήματα ως προς τις πηγές και το ένα πέμπτο περιείχε μείζονα σφάλματα ακρίβειας, όπως παραισθητικές και/ή παρωχημένες πληροφορίες».

Όταν ζητάμε ειδήσεις, θα πρέπει να περιμένουμε από τα εργαλεία γενετικής τεχνητής νοημοσύνης να παραμένουν στα γεγονότα. Εφόσον δεν το κάνουν, όποιος χρησιμοποιεί την τεχνητή νοημοσύνη ως πηγή αξιόπιστης πληροφόρησης οφείλει να κινείται με ιδιαίτερη προσοχή.