![]()

Rhett Hanscom, Tamara Silbergleit Lehman, Qin Lv, Shivakant Mishra

Πανεπιστήμιο του Κολοράντο στο Μπόλντερ

{rhett.hanscom, tamara.lehman, qin.lv, mishras}@colorado.edu

Περίληψη

Οι πλατφόρμες κοινωνικής δικτύωσης έχουν εξελιχθεί ραγδαία στη σύγχρονη εποχή χωρίς ισχυρή ρύθμιση. Ένα σαφές εμπόδιο που αντιμετωπίζουν σήμερα οι χρήστες είναι αυτό της τοξικότητας. Η τοξικότητα στα μέσα κοινωνικής δικτύωσης εκδηλώνεται με διάφορες μορφές, όπως παρενόχληση, αρνητικότητα, παραπληροφόρηση ή άλλους διχαστικούς τρόπους. Στην εργασία αυτή, χαρακτηρίζουμε τη βιβλιογραφία που σχετίζεται με την τοξικότητα, διατυπώνουμε έναν ορισμό της τοξικότητας, προτείνουμε έναν νέο κύκλο διαδικτυακού εξτρεμισμού, παραθέτουμε τις τρέχουσες προσεγγίσεις ανίχνευσης τοξικότητας, σκιαγραφούμε μελλοντικές κατευθύνσεις για τον περιορισμό της τοξικότητας σε μελλοντικές προσπάθειες στον χώρο των κοινωνικών μέσων, και εντοπίζουμε κενά στη σχετική ερευνητική βιβλιογραφία. Παρουσιάζουμε μια νέα προοπτική για τις αρνητικές επιπτώσεις των πλατφορμών κοινωνικής δικτύωσης και καλύπτουμε ένα κενό στη βιβλιογραφία, συμβάλλοντας στη βελτίωση του μέλλοντος αυτών των πλατφορμών.

Λέξεις-κλειδιά: Κατηγοριοποίηση Τοξικότητας, Τοξικότητα σε Μέσα Κοινωνικής Δικτύωσης

I. Εισαγωγή

Τα μέσα κοινωνικής δικτύωσης δεν αποτελούν πλέον ένα απλό διαδικτυακό εργαλείο για σύνδεση με φίλους, αλλά έχουν μετατραπεί σε χαρακτηριστικό γνώρισμα ενός ψηφιακού κόσμου — στον οποίο τα πρότυπα και οι πρακτικές επικοινωνίας έχουν εξελιχθεί τόσο παράλληλα όσο και έξω από εκείνα των πιο παραδοσιακών μορφών αλληλεπίδρασης. Συχνά παρατηρούμε ομάδες ανθρώπων να συμπεριφέρονται διαφορετικά σε ανώνυμα δωμάτια συνομιλίας απ’ ό,τι αν βρίσκονταν στον ίδιο φυσικό χώρο [Barlett(2015), Zimmerman and Ybarra(2016)]. Αυτό καταδεικνύει τον ρόλο της λογοδοσίας, ο οποίος μειώνεται όσο αυξάνεται η ανωνυμία.

Δεν ισχύουν απλώς διαφορετικοί κανόνες για την κοινωνικοποίηση στο διαδίκτυο — αυτοί οι κανόνες φαίνεται πως αλλάζουν με ταχύ ρυθμό. Καθώς οι εικονικές κοινότητες αποτελούν ένα από τα πιο πρόσφατα «κοινωνικά επιτεύγματα» της ανθρωπότητας, είναι λογικό αυτές οι ψηφιακές «αρένες» να παρουσιάζουν αναταράξεις μέχρι να εδραιωθούν σταθερές πρακτικές και προσδοκίες. Το φαινόμενο περιπλέκεται ακόμη περισσότερο από την πληθώρα διαθέσιμων χώρων — χώρων όπου οι άνθρωποι αλληλεπιδρούν με διαφορετικούς κανόνες εποπτείας και κοινοτικούς κανόνες.

Ως αποτέλεσμα, η τοξικότητα και τα αρνητικά πρότυπα επικοινωνίας έχουν παγιωθεί στις πλατφόρμες κοινωνικής δικτύωσης (ΠΚΔ), και αυτό συμβαίνει παράλληλα με άλλες γνωστές κρίσεις της ψηφιακής εποχής, όπως εκστρατείες παραπληροφόρησης, διαδικτυακές κουλτούρες με bots και trolls, προκατάληψη υπέρ πολωτικού και ακραίου περιεχομένου [Nelimarkka et al.(2018)], και τη διογκούμενη δυσπιστία των χρηστών απέναντι σε δημόσιους και προβεβλημένους λογαριασμούς influencers [Belanger(2021)]. Για να κατανοήσουμε τις συνολικές επιπτώσεις αυτών των φαινομένων, είναι σημαντικό να τις αναλύσουμε πρώτα ατομικά.

Τα μέσα κοινωνικής δικτύωσης είναι πανταχού παρόντα και ήρθαν για να μείνουν. Ωστόσο, έχει αποδειχθεί ότι επηρεάζουν τα άτομα με τρόπους που είναι επιζήμιοι τόσο για την υγεία τους όσο και για τη συνοχή των κοινοτήτων τους [Vogels(2021), Chu et al.(2024)]. Αν και οι εικονικές ανταλλαγές έχουν γίνει αναπόσπαστο μέρος της ανθρώπινης επικοινωνίας, οι εικονικοί χώροι δεν είναι φυσικοί χώροι — και είναι σαφές ότι οι άνθρωποι τους χρησιμοποιούν με διαφορετικούς τρόπους. Πρόσφατες έρευνες επιβεβαιώνουν αυτή τη διαφορά: το 91% των Αμερικανών θεωρεί τον διαδικτυακό εκφοβισμό και την παρενόχληση σοβαρά προβλήματα [Vogels(2021)]. Παρόλο που είναι σαφές πως η διαδικτυακή παρενόχληση αποτελεί πρόβλημα, οι αιτίες και οι συνέπειές της δεν είναι επαρκώς κατανοητές. Σε αυτή την εργασία, διερευνούμε εις βάθος τους παράγοντες που συμβάλλουν στις αρνητικές αλληλεπιδράσεις στα μέσα κοινωνικής δικτύωσης με στόχο τη βελτίωση του σχεδιασμού τους και τη δημιουργία θετικότερων ψηφιακών κοινοτήτων. Η εργασία προσφέρει τις εξής σημαντικές συνεισφορές:

• Παρέχουμε έναν ορισμό της διαδικτυακής τοξικότητας.

• Προβαίνουμε σε εις βάθος διερεύνηση του φαινομένου.

• Προτείνουμε έναν νέο κύκλο διαδικτυακού εξτρεμισμού που εμπλέκει την τοξικότητα, την παραπληροφόρηση και την πόλωση.

• Συστηματοποιούμε την καθοριστική έρευνα που τέμνεται με το πεδίο της τοξικότητας στα μέσα κοινωνικής δικτύωσης.

Ξεκινάμε παρουσιάζοντας τους παράγοντες υποκίνησης στο Τμήμα II, ορίζουμε τις παραμέτρους της συστηματοποίησής μας στο Τμήμα III και διατυπώνουμε επίσημα τον ορισμό της τοξικότητας στο Τμήμα IV. Στη συνέχεια, συζητάμε τα πιο διερευνημένα συγγενή φαινόμενα της τοξικότητας — την παραπληροφόρηση και την πόλωση — και αναλύουμε τον ρόλο κάθε πλευράς στον κύκλο του διαδικτυακού εξτρεμισμού στο Τμήμα V. Οι τρέχουσες τεχνικές ανίχνευσης εξετάζονται στο Τμήμα VI. Αναλύουμε λιγότερο κατανοητούς παράγοντες όπως τα Δημογραφικά στο Τμήμα VII, τις επιπτώσεις των στρατηγικών μετριασμού στο Τμήμα VIII, και τέλος εντοπίζουμε βασικά ερευνητικά κενά που πρέπει να καλυφθούν μελλοντικά στο Τμήμα IX.

II. Κίνητρο

Οι συζητήσεις γύρω από την τοξικότητα στις πλατφόρμες κοινωνικής δικτύωσης (ΠΚΔ) έχουν λάβει εκτεταμένες διαστάσεις στον δημόσιο διάλογο, παρά το γεγονός ότι ένας ακριβής ορισμός της τοξικότητας συχνά διαφεύγει της συζήτησης. Το ερευνητικό πεδίο έχει επίσης κατακλυστεί από μελέτες που ασχολούνται με την κατηγοριοποίηση της τοξικότητας. Ωστόσο, ένας καθολικά αποδεκτός ορισμός ή αντίληψη της τοξικότητας εξακολουθεί να είναι δύσκολο να διατυπωθεί. Αυτή η έλλειψη σαφούς ορισμού συχνά περιπλέκει τις τεχνικές εποπτείας που βασίζονται σε στατικά καθορισμένες έννοιες [Jhaver et al.(2023)]. Οι Jhaver et al. δείχνουν πώς οι χρήστες συχνά συγχέονται σχετικά με τις τεχνικές αυτορρύθμισης, οι οποίες απαιτούν κοινή κατανόηση των θεμάτων που πρόκειται να εποπτευτούν. Η απουσία κοινής συμφωνίας για το τι συνιστά τοξικότητα αφήνει κάθε ερευνητή να την ορίσει στο πλαίσιο της δικής του εργασίας — γεγονός που καθιστά τις άμεσες τεχνικές εποπτείας (είτε αυτόματες είτε βασισμένες στους ίδιους τους χρήστες), καθώς και τις συγκρίσεις μεταξύ διαφορετικών μοντέλων κατηγοριοποίησης τοξικότητας, δυσχερείς.

Παρόλο που η έρευνα γύρω από την κατηγοριοποίηση της τοξικότητας έχει σημειώσει ταχεία πρόοδο, λιγότερες μελέτες έχουν διερευνήσει τις λεπτές αποχρώσεις και τις πολυπλοκότητες του φαινομένου. Για παράδειγμα, η αντίληψη της τοξικότητας μπορεί να ποικίλλει ανάλογα με το συμφραζόμενο και το υπόβαθρο του ατόμου που βιώνει το περιστατικό [Sap et al.(2021)]. Επιπλέον, ελάχιστη έρευνα έχει γίνει για τον εντοπισμό των δημογραφικών χαρακτηριστικών όσων δέχονται ή παράγουν τοξικό περιεχόμενο. Αν και έχει τεκμηριωθεί ότι η τοξικότητα και η παρενόχληση επηρεάζουν άτομα όλων των ηλικιών και κοινωνικών ομάδων στις Ηνωμένες Πολιτείες, παραμένει ασαφές ποιος ακριβώς παράγει όλη αυτήν την τοξικότητα. Αυτό το κενό στη βιβλιογραφία είναι ανησυχητικό, δεδομένης της συχνότητας με την οποία οι διαδικτυακοί χρήστες επηρεάζονται άμεσα από αρνητικές αλληλεπιδράσεις [Vogels(2021)]. Ακόμη περισσότερο, καθώς πολλές μελέτες που εξετάζουν τις ανθρώπινες αλληλεπιδράσεις στις ΠΚΔ καταδεικνύουν ότι η τοξικότητα δεν αποθαρρύνει τη συμμετοχή, αλλά αντίθετα παρατείνει τη διάρκεια της αλληλεπίδρασης [Avalle et al.(2024), Etta et al.(2024)].

Η τοξικότητα συχνά συνυπάρχει με την παραπληροφόρηση [Cinelli et al.(2021)], την πόλωση [Vasconcellos et al.(2023)] και τις «φούσκες φίλτρων» [Shcherbakova and Nikiforchuk(2022)], γεγονός που καθιστά ακόμη πιο αναγκαία την ύπαρξη μιας συνολικής επισκόπησης αυτών των αλληλένδετων τάσεων. Προηγούμενες έρευνες έχουν προτείνει την ενσωμάτωση του συμφραζομένου στα μοντέλα μηχανικής μάθησης, δεδομένου ότι τα συμφραζόμενα είναι καθοριστικής σημασίας για τον εντοπισμό τοξικού περιεχομένου [Sheth et al.(2022)]. Η παρούσα εργασία συμπληρώνει το έργο των Sheth et al. παρέχοντας έναν επίσημο ορισμό της τοξικότητας και εμβαθύνοντας στα συμφραζόμενα που περιβάλλουν το φαινόμενο, προκειμένου να εντοπιστεί η ρίζα του προβλήματος.

Η ανάγκη για ενοποίηση της υπάρχουσας γνώσης τονίζεται και από τον μεγάλο αριθμό επιστημονικών πεδίων στην έρευνα και τη βιομηχανία που σχετίζονται με την τοξικότητα (επεξεργασία φυσικής γλώσσας, μηχανική λογισμικού, ψυχολογία, κοινωνιολογία κ.ά.), τα οποία θα ωφελούνταν από ένα ενιαίο έργο που θα ορίζει την τοξικότητα στο διαδίκτυο και θα συνοψίζει τις πιο ουσιώδεις πληροφορίες που σχετίζονται με την τοξικότητα στις πλατφόρμες κοινωνικής δικτύωσης.

IIIMethodology

| Defining Toxicity | [Salminen et al.(2020a)], [Kim et al.(2021)], [Fan et al.(2021)],[Saveski et al.(2021)], [Sheth et al.(2022)], [Almerekhi et al.(2020)] | ||

|

[Salminen et al.(2020a)], [Muneer and Fati(2020)], [Rupapara et al.(2021)],[Abro et al.(2020)], [Kumar et al.(2021)], [Fan et al.(2021)],[Sheth et al.(2022)], [Akuma et al.(2022)] | ||

| Toxicity and Filter Bubbles | [Nguyen et al.(2014)], [Nechushtai and Lewis(2019)], [Dahlgren(2021)],[Gao et al.(2023)], [Aridor et al.(2020)], [Wang et al.(2022)] | ||

|

[Au et al.(2022)], [Pascual-Ferrá et al.(2021)], [Cinelli et al.(2021)],[Salminen et al.(2020b)], [Simchon et al.(2022)] | ||

| Toxicity Demographics | [Vogels(2021)], [Cosma et al.(2020)], [Ding et al.(2020)],[Pichel et al.(2021)] |

Ο όρος «τοξικότητα» έχει πλέον ενταχθεί πλήρως στο ερευνητικό λεξιλόγιο. Ο Πίνακας I παραθέτει τις πλέον πολυαναφερόμενες μελέτες που σχετίζονται με ένα ευρύ φάσμα ζητημάτων αναφορικά με την τοξικότητα στις πλατφόρμες κοινωνικής δικτύωσης (ΠΚΔ). Όλα τα έργα που παρατίθενται στον πίνακα αποτέλεσαν αντικείμενο μελέτης στο πλαίσιο της παρούσας εργασίας. Το σκεπτικό για την επιλογή των εν λόγω έργων παρουσιάζεται ακολούθως.Λόγω του όγκου της ερευνητικής παραγωγής που αφορά τόσο την τοξικότητα στα μέσα κοινωνικής δικτύωσης όσο και του μεγάλου αριθμού επιστημονικών πεδίων που εξετάζουν τη διαδικτυακή τοξικότητα, δεν ήταν δυνατό να ληφθούν υπόψη όλα τα σχετικά έργα στο πλαίσιο αυτής της ανασκόπησης. Αντιθέτως, συμπεριλήφθηκαν μόνο έργα που έχουν δημοσιευθεί σε επιστημονικά συνέδρια και περιοδικά τα οποία είναι γνωστά για την ενασχόλησή τους με τα μέσα κοινωνικής δικτύωσης, την ψυχολογία και την επιστήμη των υπολογιστών μέσω αυστηρών διαδικασιών αξιολόγησης από ομότιμους — εκτός αν δηλώνεται διαφορετικά. Προτεραιότητα δόθηκε σε άρθρα που έχουν τουλάχιστον 40 αναφορές και έχουν δημοσιευθεί την τελευταία πενταετία. Το μεγαλύτερο μέρος των αναφερόμενων έργων προέρχεται από συνέδρια της IEEE/ACM, όπως τα CSCW, ASONAM, HCI, Human Factors in Computing Systems κ.ά., καθώς και από άλλους αξιόλογους ερευνητικούς οργανισμούς, όπως το Pew Research και οι εκδόσεις Elsevier.

IV. Ορισμός της Τοξικότητας

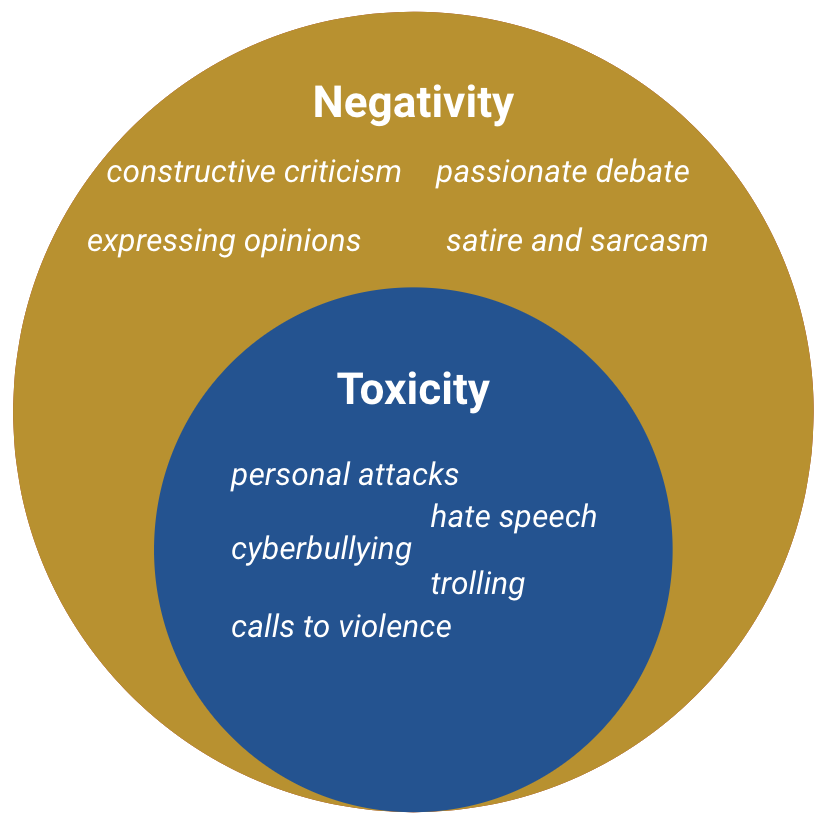

Προτείνουμε να οριστεί η τοξικότητα ως κάθε αλληλεπίδραση που απευθύνεται σε μια οντότητα με σκοπό να είναι προκλητική και σκόπιμα να καλλιεργήσει αντιπαραγωγική διχόνοια. Η τοξικότητα μπορεί να στοχεύει μια κοινότητα, ένα ιδανικό, έναν οργανισμό ή οποιαδήποτε άλλη οντότητα, και δεν είναι απαραίτητο να στρέφεται κατά συγκεκριμένου ατόμου. Βάσει του προτεινόμενου ορισμού, η τοξικότητα τίθεται πάντα σε αντίθεση με μια άλλη οντότητα, και ως εκ τούτου η τοξικότητα οφείλει να έχει πάντα έναν συγκεκριμένο στόχο, στοιχείο που τη διαφοροποιεί από την απλή αρνητικότητα. Οι αποχρώσεις μεταξύ τοξικότητας και αρνητικότητας απεικονίζονται στο Σχήμα 1.

Σύμφωνα με τον προτεινόμενο ορισμό, οι ακόλουθοι όροι εμπίπτουν στην κατηγορία της τοξικής συμπεριφοράς: ρητορική μίσους, διαδικτυακός εκφοβισμός, απειλές, χυδαιολογία και έντονα πολωμένο περιεχόμενο, εφόσον αυτές οι ενέργειες στρέφονται εναντίον κάποιας οντότητας. Η μη τοξική αρνητικότητα μπορεί να περιλαμβάνει εποικοδομητική κριτική, την έκφραση αντίθετων απόψεων, την επισήμανση παραπληροφόρησης, τον σαρκασμό ή τη σάτιρα, παθιασμένο διάλογο και δημόσια κριτική. Η αρνητικότητα μπορεί να είναι σκληρή αλλά συχνά πηγάζει από την επιθυμία για θετική αλλαγή — στοιχείο που δεν απαντάται στην τοξική συμπεριφορά.

Η τοξικότητα δεν υπάρχει αποκομμένη από το συμφραζόμενο και μπορεί να γίνεται αντιληπτή σε διαφορετικά επίπεδα από εκείνους που τη βιώνουν [Fiske(2018), Croom(2011)]. Ο προτεινόμενος ορισμός εισάγει ένα μέτρο αντικειμενικότητας στη φύσει υποκειμενική φύση της τοξικότητας. Ο σκοπός αποτελεί βασικό παράγοντα στην αναγνώριση της τοξικότητας, διαχωρίζοντάς την από τη γενική αντιπαράθεση και την απλή αρνητικότητα. Η αρνητικότητα είναι ανεξάρτητη από την τοξικότητα και μπορεί να αποτελεί μέρος μιας υγιούς διαδικτυακής αλληλεπίδρασης. Ενώ κάθε τοξικότητα είναι αρνητική, δεν είναι κάθε αρνητικότητα τοξική. Στην παρούσα εργασία χρησιμοποιούμε τον προτεινόμενο ορισμό της τοξικότητας για να συγκροτήσουμε ένα σώμα προγενέστερων μελετών με στόχο την αναγνώριση των βασικών πηγών του προβλήματος.

|

|

|

|||||||

| 2023-2024 | 21,400 | 51 | 8 | ||||||

| 2018-2024 | 82,600 | 102 | |||||||

| All Time | 899,000 | 125 |

IV-A. Προηγούμενες Προσπάθειες Ορισμού της Τοξικότητας

Ο Πίνακας II απεικονίζει την τρέχουσα κατάσταση της τοξικότητας στην ερευνητική βιβλιογραφία. Μια αναζήτηση στο Google Scholar για άρθρα που αναφέρουν τόσο την «τοξικότητα» όσο και τα «μέσα κοινωνικής δικτύωσης» σε όλα τα χρόνια επιστρέφει περίπου 900.000 αποτελέσματα. Ωστόσο, αν περιορίσουμε την αναζήτηση στα «μέσα κοινωνικής δικτύωσης» σε συνδυασμό με τουλάχιστον έναν από τους όρους «ορισμός της τοξικότητας» ή «καθορισμός της τοξικότητας», τότε προκύπτουν μόλις 125 άρθρα, εκ των οποίων τα 51 δημοσιεύτηκαν εντός ενός έτους. Από την ανασκόπηση αυτών των 51 πρόσφατων άρθρων, μόνο ένα μικρό ποσοστό παρέχει πράγματι σαφείς ορισμούς για την τοξικότητα, με τα περισσότερα να υιοθετούν είτε υπερβολικά γενικούς είτε ιδιαίτερα εξειδικευμένους ορισμούς, περιορισμένους στα όρια μιας μεμονωμένης μελέτης [Recuero(2024), Madhyastha et al.(2023)].

Σε προηγούμενες εργασίες όπου επιχειρήθηκε ο ορισμός της τοξικότητας, οι ορισμοί περιλαμβάνουν: παρενόχληση, απειλές, χυδαιολογία, προσβολές, λόγο μίσους που βασίζεται στην ταυτότητα, καθώς και κοινωνικά διαβρωτικό λόγο πειθούς [Sheth et al.(2022), Salminen et al.(2020a)]. Η τοξικότητα χρησιμοποιείται συχνά ως συνώνυμο του διαδικτυακού εκφοβισμού [Fan et al.(2021)]. Άλλες μελέτες περιγράφουν την τοξικότητα ως συμπεριφορά που επιδεικνύει έλλειψη σεβασμού προς τους άλλους [Kim et al.(2021)]. Οι διαφορές στην αντίληψη της τοξικότητας σημαίνουν ότι η ζημιά που βιώνεται και η πρόθεση πρόκλησης ζημιάς δεν ευθυγραμμίζονται πάντα [Almerekhi et al.(2020)].

Ο ορισμός της τοξικότητας από το Perspective API: «ένα αγενές, ασεβές ή παράλογο σχόλιο», έχει χρησιμοποιηθεί στην έρευνα ως βάση για τον καθορισμό της τοξικότητας [Saveski et al.(2021)]. Ορισμένοι ερευνητές έχουν συνενώσει την παραπληροφόρηση, την πόλωση και την τοξικότητα σε ένα ενιαίο φαινόμενο [Sheth et al.(2022)]. Ωστόσο, αυτή η σύγχυση των όρων ενδέχεται να έρχεται σε αντίθεση με υφιστάμενους και τεκμηριωμένους ορισμούς αυτών των φαινομένων [Vraga and Bode(2020), Kubin and von Sikorski(2021)]. Στην παρούσα εργασία επιλέγουμε να βασιστούμε σε προϋπάρχουσα έρευνα που θεμελιώνει την παραπληροφόρηση και την πόλωση ως διακριτές οντότητες και, αντιθέτως, να τοποθετήσουμε και να εντάξουμε αυτά τα φαινόμενα μαζί με τα φαινόμενα των πληροφοριακών φυσαλίδων (filter bubbles) και της τοξικότητας ως ξεχωριστά συστατικά ενός κύκλου διαδικτυακού εξτρεμισμού. Αυτή η διάκριση αναπτύσσεται περαιτέρω στην Ενότητα V.

V. Συμπροϋπάρχοντα Φαινόμενα

Οι διαδικτυακές ΠΚΔ έχουν εισαγάγει πολλά νέα φαινόμενα με συνέπειες που δεν είναι πλήρως κατανοητές ως προς την επίδρασή τους στα άτομα, με αποτέλεσμα την εντατική μελέτη τους υπό διάφορα ερευνητικά πρίσματα. Μεταξύ των φαινομένων που έχουν μελετηθεί περιλαμβάνονται οι λογαριασμοί bots και trolls, η παραπληροφόρηση, η πόλωση και το φαινόμενο των πληροφοριακών φυσαλίδων [Nguyen et al.(2014)]. Περιγράφουμε την τρέχουσα κατάσταση της επιστημονικής έρευνας για τα εν λόγω φαινόμενα και προτείνουμε μια νέα οπτική στην αλληλεπίδραση μεταξύ παραπληροφόρησης, πόλωσης και τοξικότητας, την οποία αποκαλούμε «κύκλο διαδικτυακού εξτρεμισμού».

V-A. Bots και Trolls

Για να κατανοήσουμε πώς επηρεάζονται οι άνθρωποι από την τοξικότητα, οφείλουμε επίσης να κατανοήσουμε τον ρόλο των bots και των trolls, βασικών παραγόντων στον χώρο των ΠΚΔ. Ένας troll λογαριασμός έχει ως κύριο στόχο τη δημιουργία αντιπαραθέσεων, σχολιάζοντας κυρίως προκλητικό περιεχόμενο με την πρόθεση να προκαλέσει τις πιο ακραίες αντιδράσεις. Οι bot λογαριασμοί διαχειρίζονται από προηγμένο λογισμικό, ικανό και έτοιμο να εκμεταλλευτεί τις αποχρώσεις των συζητήσεων στην προσπάθεια διαμόρφωσης της κοινής γνώμης. Αυτοί οι λογαριασμοί συχνά αποτελούν μέρος ενός μεγαλύτερου «σμήνους bots», το οποίο λειτουργεί με κοινό στόχο. Επί του παρόντος, παρόλο που οι bot λογαριασμοί αντιστοιχούν μόνο στο 5% όλων των προφίλ στο Twitter, εκτιμάται ότι το 20-30% του περιεχομένου που καταναλώνεται στις Ηνωμένες Πολιτείες προέρχεται από bots [Varanasi(2022)]. Αυτή η δυσαναλογία ποσοστών καταδεικνύει τη μεγάλη εμβέλεια που διαθέτουν οι λογαριασμοί bots.

Οι δημιουργοί των bots έχουν εργαλειοποιήσει αυτήν την ευκαιρία με διάφορους τρόπους, μεταξύ άλλων: στην προσπάθεια επηρεασμού εκλογικών αποτελεσμάτων [Dutta et al.(2021)], αποκατάστασης φήμης εταιρειών [Aydemir(2020)] και αύξησης πωλήσεων μουσικών άλμπουμ [Boyer(2021)]. Τα στοιχεία αυτά ενισχύουν την άποψη ότι τα bots δεν συμβάλλουν απαραίτητα σε τοξική συμπεριφορά, ενώ αντίθετα ένας troll λογαριασμός είναι εξ ορισμού σχεδιασμένος ώστε να την προκαλεί.

V‑B Φυσαλίδες Φίλτρου, Παραπληροφόρηση και Πόλωση

Ένα αναπόσπαστο στοιχείο για την κατανόηση της κατάστασης στις πλατφόρμες κοινωνικής δικτύωσης είναι η αύξηση της παραπληροφόρησης που έχει κατακλύσει το Διαδίκτυο τα τελευταία χρόνια [Allcott et al.(2019)]. Έχουμε δει την κυβέρνηση της Ρωσίας να εμπλέκεται σε πολλές περιπτώσεις πολιτικά υποκινούμενων εκστρατειών παραπληροφόρησης, στις οποίες σκόπιμα διαδίδει ψευδείς πληροφορίες και ενισχύει έντονα πολωμένες απόψεις ενόψει προσεχών εκλογών [Alba and Frenkel(2019), Banjo(2019), Woolley and Howard(2017), Dutta et al.(2021)]. Αν και οι εκθέσεις διαφέρουν ως προς την αποτελεσματικότητα αυτών των εκστρατειών, αποτελούν σαφή και ορατή απειλή για την ακεραιότητα του διαδικτυακού λόγου.

Η εξάπλωση της παραπληροφόρησης έχει γίνει ολοένα και πιο σύνθετη καθώς οι περισσότερες πλατφόρμες κοινωνικής δικτύωσης έχουν εισαγάγει λειτουργίες που προορίζονται να ενθαρρύνουν τους χρήστες να καταναλώνουν ειδήσεις μέσα από τα συστήματά τους. Το Facebook και το Twitter έχουν μετατραπεί σε τεράστιους παρόχους ειδήσεων, ακόμη και χωρίς να παράγουν δικό τους περιεχόμενο ή να εφαρμόζουν καλά εδραιωμένες πρακτικές επεξεργασίας — σε αντίθεση με οργανισμούς ειδήσεων που τηρούν τις δεοντολογικές δημοσιογραφικές τους ευθύνες. Έρευνες δείχνουν ότι οι λογαριασμοί που δημοσιεύουν παραπληροφόρηση είναι σημαντικά πιο πιθανό να είναι bots και μπορούν γρήγορα να κορεάσουν έναν εικονικό χώρο με περιεχόμενο [Shao et al.(2018)].

Η εισροή της παραπληροφόρησης στις ΠΚΔ έχει τεκμηριωθεί εκτενώς, αλλά εξακολουθεί να εξαπλώνεται ραγδαία. Έχει δείχθεί ότι οι χρήστες των μέσων κοινωνικής δικτύωσης δίνουν σημασία στον έλεγχο των ειδήσεων που κοινοποιούνται στα κοινωνικά μέσα, δίνοντας ιδιαίτερη σημασία στην πηγή των ειδήσεων και στο περιεχόμενο [Pidikiti et al.(2020), Pidikiti et al.(2022)]. Ωστόσο, οι άνθρωποι παίρνουν αποφάσεις για την αξιοπιστία των ειδήσεων πολύ γρήγορα και συχνά δεν σταθμίζουν όλες τις πληροφορίες που θεωρητικά θεωρούν σημαντικές όταν παίρνουν στιγμιαίες αποφάσεις για την εμπιστευτικότητα στην πραγματικότητα [Klein and O’Brien(2018), Pidikiti et al.(2020), Pidikiti et al.(2022)]. Αυτές οι μελέτες δείχνουν ότι οι χρήστες είναι πιο επιρρεπείς από ό,τι θα υπολόγιζαν, ακόμη και όταν είναι εφοδιασμένοι με πρακτικές διακρίβωσης της ακεραιότητας.

Επιπλέον, η χρήση συστημάτων προτεινόμενον περιεχομένου βασισμένων σε θέματα μπορεί να οδηγήσει στη δημιουργία «φυσαλίδων φίλτρου» (filter bubbles), συχνά αναφερόμενων ως «θαλάμων αντήχησης» (echo chambers) [Nguyen et al.(2014), Gao et al.(2023), Aridor et al.(2020)]. Ψηφιακές κοινότητες που έχουν σχηματιστεί με τέτοια αυστηρή προσήλωση σε ένα μοναδικό ιδανικό ή αντίληψη οδηγούν φυσιολογικά σε συμπεριφορές όπου μη ομοιογενείς συνεισφορές δεν γίνονται αποδεκτές. Οι διαδικτυακές «φυσαλίδες φίλτρου» δημιουργούν κύκλους όπου η παραπληροφόρηση μπορεί να ανθίσει. Άτομα συχνά προτείνονται περιεχόμενο με μια μόνο, συνήθως ακραία, οπτική γωνία. Οι χρήστες τότε οδηγιούνται να πιστέψουν ότι όλες οι άλλες απόψεις είναι περιττές. Αυτό το φαινόμενο δημιουργεί πρόβλημα, καθώς η ανάπτυξη και ο υγιής διάλογος εξαρτώνται από την εισαγωγή νέων ιδεών και νέων προοπτικών. Ως αποτέλεσμα, οι «φυσαλίδες φίλτρου» μπορούν να ωθήσουν τις κοινότητες να εστιάσουν σε έντονες πολωμένες θέσεις, αντί να κατανοούν τις αποχρώσεις σύνθετων ζητημάτων [Spohr(2017)]. Οι «φυσαλίδες φίλτρου» ενισχύουν ψυχολογικές έννοιες όπως: οι άνθρωποι γενικά θα αναζητούν υποστηρικτικές πληροφορίες παρά προκλητικές, και θα έλκονται προς άτομα με παρόμοιες απόψεις [Dahlgren(2021)]. Καθώς τα εργαλεία AI ενσωματώνονται όλο και περισσότερο στην καθημερινότητά μας, η χρήση AI στον επιμερισμό περιεχομένου μέσω αλγορίθμων σύστασης έχει οδηγήσει σε εξαιρετικά ομοιογενείς «μεσοδιατροφές» περιεχομένου (media diets) όπως αυτές που παρατηρούνται στις φυσαλίδες φίλτρου [Nechushtai and Lewis(2019)].

Δύο τύποι πόλωσης παίζουν σήμερα κρίσιμο ρόλο στα μέσα κοινωνικής δικτύωσης: η ιδεολογική και η συναισθηματική. Η ιδεολογική πόλωση ορίζεται ως η «απόκλιση των ιδανικών κατά μήκος γραμμών κομμάτων» [Kubin and von Sikorski(2021)], ενώ η συναισθηματική πόλωση αναφέρεται στον βαθμό με τον οποίο ένας χρήστης αισθάνεται ευθυγραμμισμένος ή αντίθετος με άτομα που έχουν διαφορετικές πολιτικές ταυτότητες [Kubin and von Sikorski(2021)]. Με απλά λόγια, η ιδεολογική πόλωση είναι η απόκλιση σε πολιτικά ιδεώδη, ενώ η συναισθηματική πόλωση αφορά την ενσυναίσθηση ή την αντίδραση προς όσους θεωρούνται «εκτός ομάδας».

Η σχέση μεταξύ παραπληροφόρησης και πόλωσης έχει τεκμηριωθεί εκτενώς στη σύγχρονη έρευνα [Au et al.(2022)]. Η διαθεσιμότητα και η διάδοση της παραπληροφόρησης έχει αποδειχθεί κρίσιμο στοιχείο για την καλλιέργεια έντονου λόγου και πόλωσης σε διαδικτυακές κοινότητες [Azzimonti and Fernandes(2022)]. Ιδιαίτερα για χρήστες με λιγότερη εμπειρία σε διαδικτυακούς χώρους, η έκθεση σε παραπληροφόρηση μπορεί να έχει μακροχρόνιες επιπτώσεις στον βαθμό στον οποίο αυτοί οι χρήστες θα είναι ενεργοί στις κοινότητές τους, τόσο βραχυπρόθεσμα όσο και μακροπρόθεσμα [Wang et al.(2021a)]. Αυτοί οι χρήστες συχνά κινητοποιούνται να συμμετάσχουν στο δημόσιο διάλογο, χωρίς να κατανοούν τις έντονες πολιτικές προκαταλήψεις και εξαπατήσεις που ενσωματώνονται στα μέσα που καταναλώνουν. Στην πραγματικότητα, προγενέστερες μελέτες έχουν δείξει ότι η αλληλεπίδραση με λογαριασμούς που διαχειρίζονταν καμπάνιες ρωσικής ανάμειξης στις εκλογές πριν από τις προεδρικές των ΗΠΑ το 2016 οδήγησε τους χρήστες του Twitter να ενισχύσουν τη διαδικτυακή τους συμπεριφορά [Dutta et al.(2021)]. Πολλοί από αυτούς τους χρήστες αποδείχθηκε ότι περνούσαν περισσότερο χρόνο στο Twitter μετά τις «συγκρούσεις» με αυτούς τους ρωσικούς λογαριασμούς [Dutta et al.(2021)].

Ένα σημαντικό αποτέλεσμα από προηγούμενες μελέτες κατέδειξε ότι χρήστες του Twitter που ήρθαν σε επαφή με εκστρατείες παρέμβασης έδειξαν επίσης αύξηση στην πόλωση, υπονοώντας ότι αυτά τα άτομα ενδέχεται να έχουν ωθηθεί σε ακραία ιδεολογία από τις ρωσικές επαφές [Dutta et al.(2021)]. Αν και ο αντίκτυπος της ρωσικής εκστρατείας παραπληροφόρησης στο ίδιο το εκλογικό αποτέλεσμα παραμένει εξαιρετικά αμφιλεγόμενος, το γεγονός ότι η συμπεριφορά των χρηστών άλλαξε είναι αδιαμφισβήτητο [Eady et al.(2023), Dutta et al.(2021)]. Οι [Pascual‑Ferrá et al.(2021)] επίσης ανέδειξαν μια σύνδεση μεταξύ πόλωσης και αυξημένης τοξικότητας. Άλλες μελέτες, στο YouTube, διαπίστωσαν ότι ο διαδικτυακός διάλογος τείνει να έλκεται προς την τοξικότητα [Pascual‑Ferrá et al.(2021)] και ότι τα ειδησεογραφικά θέματα επηρεάζουν τα επίπεδα τοξικότητας των χρηστών [Salminen et al.(2020b)].

V‑Γ. Κύκλος Διαδικτυακού Εξτρεμισμού και Φυσαλίδων Φίλτρου

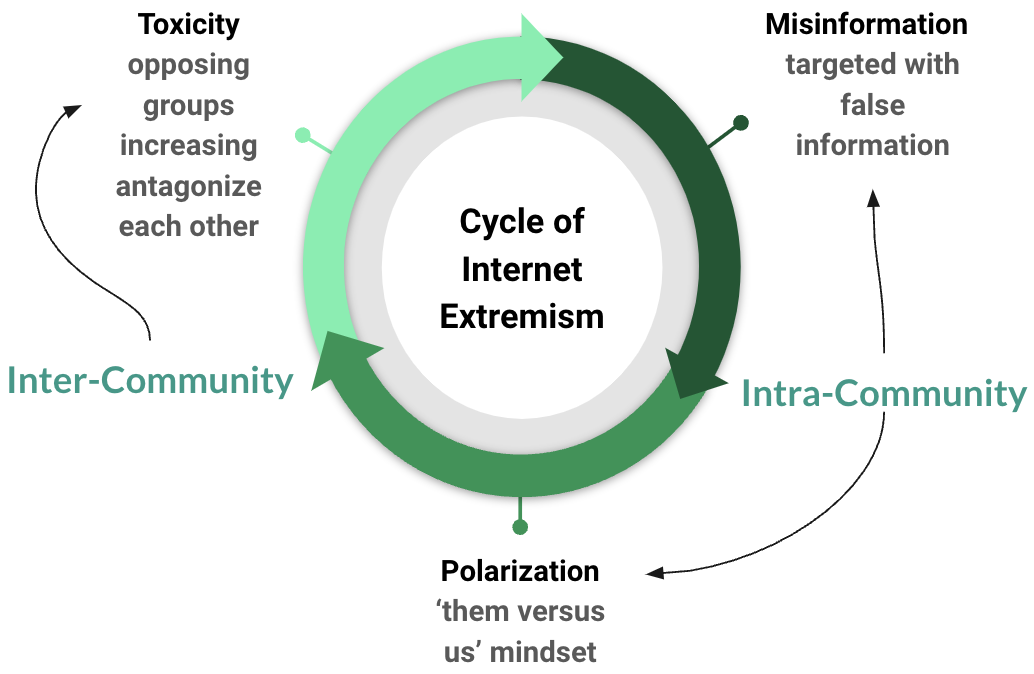

Υποστηρίζουμε ότι μέσα σε ορισμένες κοινότητες υπάρχει ένας κύκλος διαδικτυακού εξτρεμισμού και ότι αυτός συχνά ενισχύεται από τις «φυσαλίδες φίλτρου» (όπως φαίνεται στο Σχήμα 2). Οι φυσαλίδες φίλτρου, η παραπληροφόρηση και η πόλωση μερικές φορές συγχέονται σε ένα ενιαίο φαινόμενο [Sheth et al.(2022)]. Ωστόσο, προτείνουμε να εξετάζουμε αυτά τα θέματα ανεξάρτητα και ως μέρος ενός κύκλου διαδικτυακού εξτρεμισμού που οδηγεί στην τοξικότητα. Σε ορισμένες διαδικτυακές κοινότητες, η παραπληροφόρηση διαδίδεται προκαλώντας μεγαλύτερη ιδεολογική πόλωση (ενισχυμένη από τις φυσαλίδες φίλτρου), που τελικά οδηγεί σε αυξημένη συναισθηματική πόλωση, καθώς τα άτομα τίθενται όλο και περισσότερο σε νοοτροπία «εμείς εναντίον αυτών». Καθώς η πόλωση μεταξύ των μελών της κοινότητας εντείνεται, η τοξικότητα δημιουργείται ως παράγωγο αυτού του κύκλου. Αυτό υποστηρίζεται από μελέτες που διαπίστωσαν ότι στο Twitter, οι χρήστες δημοσιεύουν περισσότερο τοξικό περιεχόμενο όταν αλληλεπιδρούν με χρήστες με τους οποίους δεν έχουν κοινούς συνδέσμους [Saveski et al.(2021)]. Αυτές οι αντικοινωνικές συμπεριφορές (τοξικότητα, παραπληροφόρηση και πόλωση) συνεχίζουν να ωθούν τα μέλη της κοινότητας προς άκρα όσο συνεχίζουν να συμμετέχουν.

Δεδομένου ότι κάθε φαινόμενο που απεικονίζεται στο Σχήμα 2 μπορεί να εμφανιστεί ανεξάρτητα έξω από αυτόν τον κύκλο, προηγούμενη έρευνα έχει μελετήσει διάφορους συνδυασμούς αυτών. Για παράδειγμα, η σχέση μεταξύ φυσαλίδων φίλτρου και παραπληροφόρησης έχει βρεθεί ότι επηρεάζει την ευπιστία των χρηστών [Rhodes(2022), Lakshmanan(2022), Tomlein et al.(2021)]. Οι φυσαλίδες φίλτρου και η πόλωση έχουν επίσης συνδεθεί με νοοτροπία «φυλετικής/φυλετικής ομάδας» σε διαδικτυακές πλατφόρμες κοινωνικής δικτύωσης [Chitra and Musco(2020), Keijzer and Mäs(2022), Wolfowicz et al.(2023)]. Πολλές άλλες μελέτες έχουν εξετάσει την παραπληροφόρηση, την πόλωση και τις φυσαλίδες φίλτρου ως σύνολο [Spohr(2017), Interian et al.(2023), Simchon et al.(2022)], και έχουν βρει στενή σύνδεση ανάμεσά τους. Αν και απαιτείται σημαντική περαιτέρω έρευνα για να μετρηθεί η επίδραση που μπορεί να έχει η πόλωση στην τοξικότητα, η επίδραση των φυσαλίδων φίλτρου στην τοξικότητα μόλις αρχίζει να διερευνάται στη σχετική βιβλιογραφία — η οποία έχει δείξει ότι οι φυσαλίδες φίλτρου μπορούν συχνά να παρεμποδίσουν την κριτική ικανότητα των χρηστών [Shcherbakova and Nikiforchuk(2022)].

Ενώ πολύς κόσμος έχει διερευνήσει την αλληλεπίδραση παραπληροφόρησης και πόλωσης, η τοξικότητα στερείται ενός επίσημου ορισμού και συνεπώς είναι πιο δύσκολο να παρακολουθηθεί. Με τον ορισμό της τοξικότητας που χρησιμοποιούμε στην εργασία μας, η τοξικότητα έχει την τάση να εμφανίζεται με μορφή δια‑κοινοτικής αλληλεπίδρασης, γεγονός που καθιστά πιο δύσκολη την αναγνώρισή της. Η παραπληροφόρηση και η πόλωση συμβαίνουν κατά κανόνα σε εσωτερικό επίπεδο κοινότητας, μέσω αλληλεπιδράσεων με ομοϊδεάτες. Αντίθετα, η τοξικότητα εκτοξεύεται έξω, μέσω πολωμένων αλληλεπιδράσεων με άτομα εκτός της ομάδας (out‑group). Αυτό κάνει την τοξικότητα κάπως πιο δύσκολη στην ιχνηλάτηση, καθώς είναι απο‑κεντρωμένη και μπορεί να εμφανιστεί παντού, σε αντίθεση με την παραπληροφόρηση και το πολωμένο περιεχόμενο που συγκεντρώνονται ανεμπόδιστα εντός των ορίων της κοινότητας. Όταν εξεταστεί μέσα σε αυτό το πλαίσιο, η τοξικότητα μπορεί να θεωρηθεί ως άμεσο αποτέλεσμα έντονης συναισθηματικής πόλωσης — ως συνέπεια της μειωμένης ενσυναίσθησης προς όσους έχουν αντίθετα ιδεώδη. Αυτή η οπτική εδραιώνει κάθε μορφή αντι‑κοινωνικής συμπεριφοράς ως ξεχωριστή δράση, αν και στην πραγματικότητα είναι βαθιά περίπλοκη και συνυφασμένη.

VI Τρέχουσες Προσεγγίσεις στην Ανίχνευση Τοξικότητας

Τα μοντέλα μηχανικής μάθησης (ML) χρησιμοποιούνται τυπικά για την ανίχνευση τοξικότητας στις πλατφόρμες κοινωνικής δικτύωσης (ΠΚΔ). Προηγούμενη έρευνα έχει προσφέρει στέρεες αξιολογήσεις για το ποιοι συνδυασμοί μοντέλων ML και τεχνικών εξαγωγής χαρακτηριστικών οδηγούν στις πιο ακριβείς μεθόδους [Abro et al.(2020), Muneer and Fati(2020)].

Οι σύγχρονες ML προσεγγίσεις για κατηγοριοποίηση δεν μπορούν να λειτουργήσουν μόνο με κείμενο. Το κείμενο πρέπει να μετατραπεί σε αριθμητικά δεδομένα για να κατηγοριοποιηθεί από τα περισσότερα μοντέλα ML. Πρόκειται για ένα κρίσιμο βήμα, καθώς η πληροφορία που παράγεται για την εκπαίδευση ενός ταξινομητή θα διαμορφώσει άμεσα τη συμπεριφορά του. Αυτό το βήμα χρησιμοποιεί ένα εργαλείο δημιουργίας χαρακτηριστικών για να κάνει τη μετατροπή. Το καλύτερο εργαλείο δημιουργίας χαρακτηριστικών εξαρτάται τόσο από τα δεδομένα όσο και από τον τύπο των συμπερασμάτων που γίνονται [Abro et al.(2020), Muneer and Fati(2020)].

Η κατηγοριοποίηση της τοξικότητας έχει παραδοσιακά θεωρηθεί ως εργασία επιβλεπόμενης μάθησης – που σημαίνει ότι τα μοντέλα εκπαιδεύονται με προ-επισημασμένα παραδείγματα τοξικότητας, με αποστολή να μάθουν από αυτά τα παραδείγματα ώστε αργότερα να κατηγοριοποιούν έγγραφα. [Abro et al.(2020)] καθώς και [Muneer and Fati(2020)] δοκίμασαν αρκετούς δημοφιλείς συνδυασμούς εργαλείων δημιουργίας χαρακτηριστικών και επιβλεπόμενων μοντέλων ML σε σύνολα προ-επισημασμένων tweets. Ο Abro et al.(2020) συνέδεσε οκτώ επιβλεπόμενα μοντέλα ML και τρία εργαλεία δημιουργίας χαρακτηριστικών για να ταξινομήσει ξεχωριστά κείμενα σε «ρητορική μίσους», «όχι προσβλητικό», και «προσβλητικό αλλά όχι ρητορική μίσους». Ένα σημαντικό συμπέρασμα από αυτή την εργασία είναι ότι κανένας συνδυασμός επιβλεπόμενου μοντέλου ML και εργαλείου δημιουργίας χαρακτηριστικών δεν είναι ανώτερος από όλους τους υπόλοιπους με κάθε τρόπο· μάλλον ορισμένοι συνδυασμοί είναι καλύτεροι για συγκεκριμένα καθήκοντα και σύνολα δεδομένων. Η προσαρμογή ταξινομητών τοξικότητας σε επίπεδο κοινότητας, που επηρεάζει διαφορετικά άτομα σε μειονεκτική θέση, μπορεί να βελτιώσει την αποτελεσματικότητα γενικά εκπαιδευμένων μοντέλων (όπως το Perspective API της Jigsaw) [Kumar et al.(2021)]. Οι Sheth et al. του 2022 υπογράμμισαν τον κρίσιμο ρόλο του συμφραζομένου στην κατηγοριοποίηση τοξικότητας [Sheth et al.(2022)].

Ένα ευρέως χρησιμοποιούμενο μοντέλο ML είναι η Logistic Regression. Η Logistic Regression κατασκευάζει ένα ξεχωριστό υπερεπίπεδο ανάμεσα σε δύο σύνολα δεδομένων χρησιμοποιώντας τη λογιστική συνάρτηση [Patchin and Hinduja(2011)]. Η Logistic Regression λαμβάνει έναν αριθμό σταθμισμένων χαρακτηριστικών ως είσοδο και παράγει μια δυαδική απόφαση σε εργασίες κατηγοριοποίησης. Ένα άλλο μοντέλο με υψηλές επιδόσεις, το Random Forest, χρησιμοποιεί έναν αριθμό δέντρων αποφάσεων και μηχανισμούς τυχαίας ψηφοφορίας, κατά μέσο όρο συνδυάζοντας αποτελέσματα για να ενισχύσει την προβλεπτική ακρίβεια και να μειώσει την υπερπροσαρμογή [Dadvar et al.(2013)]. Το Support Vector Machine (SVM) είναι ένας ακόμη επιβλεπόμενος ταξινομητής ML που χρησιμοποιείται συχνά για εργασίες ταξινόμησης κειμένου. Το SVM μετασχηματίζει ένα αρχικό σύνολο χαρακτηριστικών προβολικά σε έναν χώρο μεγαλύτερων διαστάσεων που ορίζεται από έναν kernel. Ο στόχος του είναι να μεγιστοποιήσει το περιθώριο, ή την απόσταση, ανάμεσα στις κατηγορίες, εντοπίζοντας support vectors — τα δείγματα από κάθε κατηγορία που βρίσκονται πιο κοντά στο διαχωριστικό υπερεπίπεδο που προσεγγίσθηκε αρχικά. Στην [Joachims(1998)] δείχθηκε ότι η ακρίβεια του SVM μειώνεται καθώς αυξάνεται το μέγεθος των δεδομένων.

Ενώ ο αλγόριθμος SVM σε συνδυασμό με δημιουργία χαρακτηριστικών bigram ταξινομεί πιο επιτυχώς έγγραφα σύμφωνα με την [Abro et al.(2020)], μια παρόμοια ανάλυση από τους [Muneer and Fati(2020)] βρήκε ότι η Logistic Regression ήταν πιο ακριβής στην ανίχνευση διαδικτυακού εκφοβισμού (cyberbullying) στο Twitter. Τα δέντρα αποφάσεων επίσης έχουν δείξει ότι συνδυάζονται ευνοϊκά με την κατηγοριοποίηση σύντομων εγγράφων όπως τα tweets [Akuma et al.(2022)].

Λόγω της σχετικής σπανιότητας τοξικού περιεχομένου σε σύγκριση με το μη τοξικό περιεχόμενο του διαδικτύου, οι ταξινομητές τοξικότητας συχνά δυσκολεύονται με ανισόρροπα σύνολα δεδομένων. Η υπερανάλυση (over‑sampling) τοξικών σχολίων με τη μέθοδο SMOTE είναι ένας τρόπος εξισορρόπησης των δεδομένων εκπαίδευσης [Rupapara et al.(2021)]. Άλλες λύσεις περιλαμβάνουν δειγματοληψία με K‑Nearest Neighbors, παραλλαγές του SMOTE (Borderline‑SMOTE, DBSMOTE κ.λπ.) και υποδειγματοληψία (under‑sampling) [Wang et al.(2021b)].

Τα μη επιβλεπόμενα μοντέλα ML δεν εκπαιδεύονται σε επισημασμένα δεδομένα αλλά προ-εκπαιδεύονται σε μεγάλα σώματα κειμένων και μαθαίνουν να ανιχνεύουν τη δομή, τα συμφραζόμενα και τη σημασιολογία του κειμένου με την πρόβλεψη ελλειπόντων λέξεων σε μια πρόταση, την κατανόηση σχέσεων μεταξύ λέξεων και τη δημιουργία συνεκτικού κειμένου. Πιο πρόσφατα, μη επιβλεπόμενα ML μοντέλα — όπως τα GPT και BERT — έχουν γίνει αρκετά εξελιγμένα ώστε να επιτρέπουν την εφαρμογή τους σε επιβλεπόμενες εργασίες κατηγοριοποίησης. Νέες εφαρμογές μη επιβλεπόμενων ML μοντέλων στην επιβλεπόμενη εργασία της κατηγοριοποίησης τοξικότητας έδειξαν υποσχόμενα αποτελέσματα [Sun et al.(2019)]. Αυτό επιτυγχάνεται με fine‑tuning των προ-εκπαιδευμένων μοντέλων σε μικρότερα, συχνά επισημασμένα σύνολα δεδομένων, προσφέροντας την κατανόηση των επισημασμένων δεδομένων παράλληλα με την ευρεία γνώση συμφραζομένου που αποκτήθηκε κατά την προ-εκπαίδευση.

Οι [Rasmussen et al.(2024)] πρότειναν ένα υπερ-μη επιβλεπόμενο υβριδικό μοντέλο που συνδυάζει χαρακτηριστικά και των δύο προσεγγίσεων για να επισημάνει δεδομένα χωρίς να χρειάζεται προ-επισημασμένο σύνολο εκπαίδευσης. Σε σύγκριση με το ευρέως χρησιμοποιούμενο Perspective API (το οποίο συζητείται περαιτέρω στην ενότητα VIII‑A), [Rasmussen et al.(2024)] κατάφερε να εντοπίσει με ακρίβεια τη «πολιτική ρητορική μίσους» (political hate). Η απομάκρυνση από επισημασμένα σύνολα δεδομένων θα μπορούσε να οδηγήσει σε πιο επιτυχημένη και λιγότερο προκατειλημμένη κατηγοριοποίηση τοξικότητας, δεδομένου ότι έχει δείξει ότι η προκατάληψη των επιμελητών (annotator bias) μπορεί να εισάγει μεροληψία στα επιβλεπόμενα μοντέλα ML [Sap et al.(2021)]. Άλλες μελέτες έχουν βρει ότι τα μη επιβλεπόμενα μοντέλα μάθησης, όπως το GPT, αποδίδουν εξαιρετικά καλά στην κατηγοριοποίηση σύντομων κειμένων [Balkus and Yan(2022)] — πρόβλημα που συχνά ανακύπτει κατά την ταξινόμηση δημοσιεύσεων σε μέσα κοινωνικής δικτύωσης. Το BERT έχει παρόμοια αποδειχθεί ότι υπερέχει σε εργασίες κατηγοριοποίησης τοξικότητας με μεγάλο αριθμό πολύπλοκων χαρακτηριστικών [Salminen et al.(2020a), Fan et al.(2021)]. Πέρα από την απλή ανίχνευση εισερχόμενης τοξικότητας σε ΠΚΔ, οι Almerekhi et al. (2020) πέτυχαν να προβλέπουν μη τοξικά σχόλια που θα επέφεραν τοξικές απαντήσεις σε συγκεκριμένες κοινότητες στο Reddit χρησιμοποιώντας νευρωνικό δίκτυο σε συνδυασμό με το BERT [Almerekhi et al.(2020)].

VII. Δημογραφικά και Συμπεριφορές

Αν και η διαδικτυακή παρενόχληση μπορεί να συμβεί σε πλήθος εικονικών χώρων, η πλειονότητα των ατόμων ανέφερε ότι η πιο πρόσφατη εμπειρία τους συνέβη στα μέσα κοινωνικής δικτύωσης [Vogels(2021)]. Δεδομένης της αύξησης της χρήσης των μέσων κοινωνικής δικτύωσης μεταξύ ενηλίκων ηλικίας 65 ετών και άνω [Perrin(2015)], είναι σαφές ότι η διαδικτυακή παρενόχληση δεν είναι πρόβλημα μόνο για παιδιά και νέους ενήλικες, αλλά αποτελεί επείγουσα ανησυχία για οποιοδήποτε άτομο που βρίσκεται σε αλληλεπίδραση με άλλους στο διαδίκτυο.

VII-A Χρήστες που λαμβάνουν τοξικό περιεχόμενο

Προηγούμενες μελέτες διαπιστώνουν ότι ένας εντυπωσιακός αριθμός χρηστών του διαδικτύου βιώνει καθημερινά διαδικτυακή παρενόχληση. Πολλές έρευνες από διάφορα μέρη του κόσμου έχουν καταγράψει ότι περίπου το 30% των εφήβων δέχονται ενεργά εκφοβισμό [Ding et al.(2020), Pichel et al.(2021)]. Μια άλλη μελέτη βρήκε ότι σχεδόν οι μισοί νέοι που ανέφεραν ότι υπέστησαν cyber‑bullying ανέφεραν επίσης παραδοσιακό bullying, υπογραμμίζοντας τη σοβαρότητα αυτού του ζητήματος [Cosma et al.(2020)]. Μια έκθεση του 2021 του Pew Research Center, που διερεύνησε μόνο ενήλικες, έδειξε ότι το 41% των Αμερικανών αναφέρει ότι έχει βιώσει διαδικτυακή παρενόχληση και το 25% αναφέρει ότι έχει βιώσει σοβαρή διαδικτυακή παρενόχληση [Vogels(2021)]. Αν ληφθούν υπόψη μόνο οι νέοι ενήλικες (ηλικίας 18 έως 29 ετών), το 64% δηλώνει ότι έχει βιώσει διαδικτυακή παρενόχληση, με το 48% εξ αυτών να αναφέρει σοβαρή παρενόχληση [Vogels(2021)]. Δεδομένου του δυσανάλογου ποσοστού νέων που αντιμετωπίζουν διαδικτυακή παρενόχληση, το πρόβλημα αυτό θα συνεχίσει να αυξάνεται όσο οι νεότερες γενιές είναι περισσότερο «συνδεδεμένες» στα μέσα κοινωνικής δικτύωσης.

Εκτός από την ηλικία, έχει διαπιστωθεί ότι το φύλο και η φυλή συνδέονται με την παρενόχληση. Αν και οι άνδρες αναφέρουν υψηλότερα ποσοστά παρενόχλησης από τις γυναίκες, περισσότερες γυναίκες αναγνωρίζουν το φύλο ως μέρος της παρενόχλησης (περίπου οι μισές). Ενώ μόνο το 12% των ενηλίκων αναφέρουν ότι η φυλή συνέβαλε στην παρενόχληση που δέχτηκαν, είναι επίσης αλήθεια ότι οι μαύροι και οι ισπανόφωνοι Αμερικανοί (περίπου 47%) είναι πιο πιθανό από τους λευκούς Αμερικανούς (περίπου 40%) να βιώσουν τοξικότητα με ρατσιστικά κίνητρα [Vogels(2021)].

Η διαφορά φύλου επηρεάζει επίσης τον τύπο της παρενόχλησης. Οι άνδρες είναι πιο πιθανό να αντιμετωπίσουν προσβολές και σωματικές απειλές, ενώ οι γυναίκες αναφέρουν υψηλότερα ποσοστά σεξουαλικής παρενόχλησης [Vogels(2021)]. Αυτή η επίδραση είναι ιδιαίτερα έντονη για νεότερες γυναίκες (έως 35 ετών), στις οποίες το 33% έχει δηλώσει ότι έχει δεχτεί σεξουαλική παρενόχληση online [Vogels(2021)]. Η ίδια έρευνα σημείωσε τη ραγδαία αύξηση των αυτοαναφερόμενων περιστατικών σεξουαλικής παρενόχλησης εναντίον γυναικών, τα οποία έχουν διπλασιαστεί από την τελευταία μεγάλη έρευνα που διεξήχθη τέσσερα χρόνια νωρίτερα.

VII-B Χρήστες που δημοσιεύουν τοξικό περιεχόμενο

Δυστυχώς, έχει δοθεί πολύ μικρή έμφαση στην κατανόηση του ποιοι είναι οι διαδικτυακοί παρενοχλητές και ποια δημογραφικά χαρακτηριστικά διαθέτουν [Mall et al.(2020), Vaidya et al.(2024)]. Οι Mall et al. διαχωρίζουν τους χρήστες του Reddit που δημοσιεύουν τοξικά σχόλια σε τέσσερις υποκατηγορίες με αύξουσα σειρά εμφάνισης:

- Fickle‑Minded Users, που συχνά δημοσιεύουν τόσο τοξικά όσο και μη τοξικά σχόλια (31.2%),

- Pacified Users, των οποίων τα σχόλια έγιναν λιγότερο τοξικά με τον καιρό (25.8%),

- Radicalized Users, των οποίων τα σχόλια έγιναν ολοένα και πιο τοξικά με την πάροδο του χρόνου (25.4%), και

- Steady Users, των οποίων τα επίπεδα τοξικότητας παρέμειναν σταθερά με την πάροδο του χρόνου (17.6%).

Αυτό το εύρημα υποστηρίζει μια υπόθεση από προηγούμενες μελέτες ότι υπάρχει πιθανώς μεγάλη επικάλυψη μεταξύ των χρηστών που βιώνουν και εκείνων που δημοσιεύουν τοξικό περιεχόμενο σε εικονικούς χώρους [Garaigordobil(2015)]. Μια άλλη μελέτη διαπίστωσε ότι η έκθεση σε τοξικά σχόλια οδηγεί τα άτομα στη συνέχεια να δημοσιεύσουν περισσότερο τοξικό περιεχόμενο [Kim et al.(2021)]. Σημειώστε ότι απαιτείται περαιτέρω έρευνα για να διερευνηθούν οι αιτίες αυτού του φαινομένου. Όπως αναφέρθηκε προηγουμένως, χωρίς μια σταθερή κατανόηση των λόγων για τους οποίους κάποιος παρενοχλεί άλλους στο διαδίκτυο, δεν μπορούμε να κάνουμε υποθέσεις για την ύπαρξη αυτής της συμπεριφοράς. Νέες ΠΚΔ που εμφανίστηκαν τα τελευταία χρόνια προσπάθησαν να μειώσουν το τοξικό περιεχόμενο, μειώνοντας το χάσμα μεταξύ της φυσικής και της εικονικής ζωής των χρηστών τους, όπως φαίνεται από πλατφόρμες όπως οι TikTok, BeReal και Instagram. Ωστόσο, δεν έχει σημειωθεί σημαντική πρόοδος όσον αφορά στη μείωση του τοξικού περιεχομένου.

Μια πιθανή εξήγηση για την επικάλυψη των χρηστών θα μπορούσε να φωτιστεί από τα ευρήματα μιας πιο πρόσφατης μελέτης, η οποία δείχνει ότι μόνο περίπου 1.4% των χρηστών φέρνουν λιγότερη τοξικότητα στις διαδικτυακές κοινότητες από ό,τι λαμβάνουν [Vaidya et al.(2024)]. Οι Vaidya et al. κατηγοριοποιούν χρήστες του Twitter με βάση τη διασπορά τοξικού περιεχομένου χρησιμοποιώντας τις βαθμολογίες του Perspective API της Google (δείτε Ενότητα VIII‑B για λεπτομέρειες) [Perspective API(2021b)]. Σε αυτή τη μελέτη, οι συγγραφείς αξιολόγησαν μια περίοδο 12 μηνών το 2017 από ένα σύνολο δεδομένων του Twitter και εξέτασαν τη διασπορά τοξικού περιεχομένου μέσα στο δίκτυο. Διαπίστωσαν ότι μόνο το 1.4% των χρηστών κοινοποιούν λιγότερο τοξικό περιεχόμενο από αυτό που λαμβάνουν, το 5.3% των χρηστών προσθέτουν περισσότερο τοξικό περιεχόμενο από αυτό που λαμβάνουν και περίπου το 93.3% των χρηστών κοινοποιούν το ίδιο ποσό τοξικού περιεχόμενου που λαμβάνουν. Αυτά τα αποτελέσματα δείχνουν ότι το τοξικό περιεχόμενο συχνά κοινοποιείται με μεγαλύτερη συχνότητα από το μη τοξικό, καθιστώντας ακόμη πιο δύσκολη την ταυτοποίηση των δημιουργών τοξικού περιεχομένου.

Αντίθετα, η γειτονικής βάσης πλατφόρμα NextDoor έχει μελετηθεί για να κατανοηθεί πώς η ξενοφοβία έγινε τόσο χαρακτηριστικό στοιχείο σε μια υπηρεσία που προοριζόταν να υποστηρίζει την κοινότητα μεταξύ ατόμων που ζουν κοντά [Bloch(2022), Kurwa(2019), Payne(2017)].

VIII Αντιμετώπιση της Τοξικότητας

Καθώς η επίγνωση και η κατανόηση της διαδικτυακής τοξικότητας προχωρούν, το ίδιο έχουν κάνει και τα εργαλεία μετριασμού. Εκτός από την ανάπτυξη συστημάτων για την αναγνώριση επιβλαβών δημοσιεύσεων, ερευνητές έχουν διερευνήσει συστήματα που μπορούν να ελαχιστοποιήσουν την εμφάνιση τοξικότητας.

VIII‑A Στρατηγικές Πλατφορμών Κοινωνικής Δικτύωσης

Προς το παρόν οι περισσότερες μεγάλες ΠΚΔ έχουν επίσημες θέσεις που τοποθετούνται ενάντια στη διαδικτυακή παρενόχληση, και προσφέρουν στους χρήστες τους μέσα αναφοράς φερόμενης παρενόχλησης [Twitter(2023a), Twitter(2023b), Facebook(2023), Reddit(2023)]. Ορισμένες από τις τρέχουσες στρατηγικές παρέμβασης που ενδυναμώνουν χρήστες και κοινότητες να αυτο-ρυθμίζονται φαίνεται να είναι αποτελεσματικές.

Το 2021, το Twitter εισήγαγε μια νέα λειτουργία που αξιολογεί «απαντήσεις», κατά την οποία όταν ένας χρήστης απαντά σε ανάρτηση άλλου χρήστη, ελέγχει για ενδεχόμενο επιβλαβές λεξιλόγιο [Diaz(2021)]. Αν η απάντηση κριθεί επιβλαβής, το Twitter προτρέπει τον χρήστη να εξετάσει την απάντησή του και να σκεφτεί να την αναδιατυπώσει ή να αποφεύγει το σχολιασμό. Οι Diaz et al. διαπίστωσαν ότι το 34% των χρηστών επέλεξαν να διαγράψουν την απάντησή τους σε αυτό το σημείο [Diaz(2021)].

Το 2019, το Facebook έδωσε μεγαλύτερο έλεγχο στους συντονιστές ομάδων του, επιτρέποντάς τους να χρησιμοποιούν το εργαλείο για να εντοπίζουν τοξικές δημοσιεύσεις [Hanbury([n. d.])]. Πριν από αυτή την αλλαγή, οι χρήστες ιδιωτικών ομάδων του Facebook μπορούσαν να δημοσιεύουν επιβλαβές περιεχόμενο. Δεδομένου ότι αυτές οι ομάδες λειτουργούσαν σε «μαύρο κουτί» εκτός της εποπτείας του Facebook, δεν χρειαζόταν να συμμορφωθούν με τις πολιτικές κατά της παρενόχλησης του Facebook. Παρόλο που αυτές οι στρατηγικές είναι προς τη σωστή κατεύθυνση, δεν έχουν γίνει μελέτες για την αποτελεσματικότητα του Facebook στην καταπολέμηση του τοξικού περιεχομένου.

Το παιχνίδι League of Legends είναι ένα επιτυχημένο παράδειγμα για το πώς να αντιμετωπιστεί η διαδικτυακή παρενόχληση, χειριζόμενο τις συγκρούσεις μεταξύ παικτών μέσω ενός «δικαστηρίου των ομοτίμων». Σε αυτό το παιχνίδι, όπου ομάδες παικτών αναμετρώνται διαδικτυακά και επιτρέπεται η επικοινωνία μέσω συστήματος chat, οι παίκτες συχνά αντιμετωπίζουν «δίκες ομοτίμων» για να εξεταστεί το log της συνομιλίας και να αποφασιστεί αν η συμπεριφορά δικαιολογεί περαιτέρω έρευνα. Αν η υπόθεση κλιμακωθεί, το παιχνίδι μοιάζει με το μοντέλο δικαστηρίου στις ΗΠΑ, όπου επιλέγονται τυχαία παίκτες για να αποφασίσουν το αποτέλεσμα της διαμάχης. Μια μελέτη που εξέτασε την αποτελεσματικότητα αυτής της διαδικασίας διαπίστωσε ότι συντριπτικό 92,98% κρίθηκαν «ένοχοι» [Ehrett(2016)].

Παρόλο που οι υπάρχουσες ΠΚΔ έχουν κάνει ορισμένες προσπάθειες στην καταπολέμηση της διαδικτυακής τοξικότητας, το 2021 το 82% των Αμερικανών δεν πίστευε ότι οι ΠΚΔ είχαν κάνει «καλή δουλειά» στην αντιμετώπιση της τοξικότητας [Vogels(2021)]. Στην πραγματικότητα, το 55% των ερωτηθέντων ανέφερε τη διαδικτυακή παρενόχληση ως σοβαρό πρόβλημα (και ένα συντριπτικό 91% συμφώνησε ότι ήταν τουλάχιστον μια μικρή ανησυχία). Αυτά τα ίδια άτομα ζητούσαν από τις ΠΚΔ να τα προστατεύσουν από πιθανώς επιβλαβές περιεχόμενο, αλλά οι ΠΚΔ συνεχίζουν να δίνουν προτεραιότητα στη μονομετοχική εκμετάλλευση περιεχομένου έναντι της εμπειρίας και της ασφάλειας των χρηστών. Δυστυχώς, μόνο μια μειοψηφία των Αμερικανών υποστηρίζει σήμερα να καθίσουν οι ΠΚΔ νομικά υπεύθυνες για το περιεχόμενο που δημοσιεύεται στις υπηρεσίες τους.

VIII‑B Ταυτοποίηση Τοξικότητας

Τα τελευταία χρόνια έχουν υπάρξει αρκετές μελέτες που αξιοποιούν πιο ανθεκτικές δυνατότητες ML για την ταυτοποίηση τοξικότητας [He et al.(2023), Pavlopoulos et al.(2021), Li et al.(2024), Salminen et al.(2020a)]. Το πλαίσιο Perspective API της Google είναι ένα από αυτά τα εργαλεία που χρησιμοποιούν μηχανική μάθηση για να αξιολογούν τη «τοξικότητα» σχολίων σε πολλές γλώσσες [Perspective API(2021b)]. Ο ορισμός τοξικότητας του Perspective API είναι «ένα αγενές, ασεβές ή παράλογο σχόλιο που πιθανώς θα κάνει τους ανθρώπους να φύγουν από μια συζήτηση». Το API συλλέγει έναν αριθμό χαρακτηριστικών, όπως επιθέσεις ταυτότητας, προσβολές, χυδαιολογία και απειλή, για να τα συνοψίσει σε μια μοναδική βαθμολογία τοξικότητας. Το πρόβλημα με αυτόν τον ορισμό τοξικότητας είναι ότι βασίζεται σε ρητές λέξεις, καθιστώντας το ευάλωτο σε ανθρώπινες προκαταλήψεις και αγνό ως προς το συμφραζόμενο [Goyal et al.(2022)].

Η σημασία ενός συμφωνημένου ορισμού για την τοξικότητα δεν μπορεί να υποτιμηθεί. Το Perspective API έχει χρησιμοποιηθεί για τη διαχείριση της εποπτείας σχολίων σε αρκετά γνωστά websites όπως The New York Times και Disqus [Perspective API(2021a)]. Ωστόσο, δεδομένης της ευθραυστότητας του ορισμού της τοξικότητας, προηγούμενη έρευνα έχει δείξει πώς μπορούν να μειώσουν σημαντικά την ακρίβεια ανίχνευσης του Perspective API με ελαφρές τροποποιήσεις λέξεων σε μια πρόταση [Hosseini et al.(2017), Jain et al.(2018)]. Επιπλέον, δεδομένου ότι ο ταξινομητής βασίζεται σε ανθρώπινες επισημάνσεις (annotations), είναι κρίσιμο να οριστεί επίσημα η τοξικότητα για να αποφευχθεί η προκατάληψη των επιμελητών (annotator bias) [Goyal et al.(2022)].

VIII‑C Στρατηγικές Έρευνας

Το ακαδημαϊκό περιβάλλον επιτρέπει την διερεύνηση πιο αφηρημένων μεθόδων καταπολέμησης της τοξικότητας. Ορισμένοι τρόποι με τους οποίους οι ερευνητές αντιμετωπίζουν την τοξικότητα εστιάζουν στην καλλιέργεια καλύτερης κατανόησης των αιτίων της. Μόνο μέσω μιας σταθερής κατανόησης των παραγόντων που συμβάλλουν στην τοξικότητα στους διαδικτυακούς χώρους μπορούμε να αρχίσουμε να την καταπολεμούμε. Οι ερευνητές έχουν μελετήσει τέσσερις διαφορετικούς παράγοντες για την αντιμετώπιση της τοξικότητας: τις επιδράσεις του echo‑chamber, την αυτορύθμιση, την ανωνυμία έναντι της λογοδοσίας, και το μέγεθος των κοινοτήτων.

VIII‑C1 Επιδράσεις Echo Chamber

Μία βασική ιδέα είναι ότι καθώς τα συστήματα συστάσεων εφαρμόζονται ευρέως στις ΠΚΔ, η πόλωση μεταξύ χρηστών σε διαφορετικούς “κύκλους” μεγαλώνει και ως εκ τούτου η τοξικότητα αυξάνεται [Grossetti et al.(2020)]. Αυτά τα echo‑chambers συχνά διαμορφώνονται ή ενισχύονται από ένα σύστημα συστάσεων που παρουσιάζει στους χρήστες νέους λογαριασμούς ή περιεχόμενο. Ένας τρόπος να σπάσει το φαινόμενο δημιουργίας φυσαλίδας φίλτρου από τα συστήματα συστάσεων είναι να δημιουργηθούν συστήματα που διασφαλίζουν ότι οι προτάσεις προς χρήστες δημιουργούν κοινότητες με ποικίλες ιδεολογίες (όπως οι “Community Aware Recommendations”) [Grossetti et al.(2020)].

VIII‑C2 Αυτορρύθμιση σε Διαδικτυακές Κοινότητες

Προηγούμενη έρευνα που διερεύνησε κοινότητες με αυτορύθμιση βρήκε ότι η αυτο-ρύθμιση είναι πιο αποτελεσματική σε μικρότερες κοινότητες και ότι οι μεγαλύτερες κοινότητες είναι πιο δεκτικές σε αυτοματοποιημένα εργαλεία ανίχνευσης παρενόχλησης [Seering(2020)]. Ένα κανάλι στην πλατφόρμα Twitch διαπίστωσε τέσσερις φορές περισσότερες περιπτώσεις παρενόχλησης που ανιχνεύθηκαν από bots σε σύγκριση με αυτές που επισημάνθηκαν από χρήστες, ακόμη και όταν ο ίδιος αριθμός bots και χρηστών ήταν παρών. Αυτό το αποτέλεσμα ίσως υποδεικνύει ότι οι χρήστες είναι λιγότερο πιθανό να αναλάβουν τη δράση επισημείωσης παρενόχλησης και επισημαίνει τα προβλήματα των μεγάλων πλατφορμών στην εποπτεία μεγάλου όγκου περιεχομένου.

VIII‑C3 Ανωνυμία έναντι Λογοδοσίας

Για να κατανοήσουμε καλύτερα τον συμβιβασμό μεταξύ ανωνυμίας και λογοδοσίας, μία μελέτη ακολούθησε την πηγή ειδήσεων Huffington Post μέσα από τρεις διαφορετικές πολιτικές σχετικά με την ανωνυμία σχολίων [Moore et al.(2021)]. Οι κανόνες ταυτότητας στην Huffington Post αρχικά επέτρεπαν στους χρήστες να δημοσιεύουν σχόλια χωρίς να δημιουργούν λογαριασμό, επιτρέποντάς τους να χρησιμοποιούν οποιοδήποτε όνομα επιθυμούσαν για το σχόλιό τους. Η επόμενη φάση απαίτησε από τους χρήστες να δημιουργήσουν λογαριασμό πριν σχολιάσουν, επιτρέποντας στους χρήστες να χρησιμοποιούν «σταθερά ψευδώνυμα» όταν δημοσίευαν σχόλια. Η τελική πολιτική κατήργησε το εσωτερικό σύστημα χρηστών και απαίτησε οι χρήστες να συνδέουν τα σχόλιά τους με τα προφίλ τους στο Facebook. Αυτή η τελευταία φάση σήμαινε ότι οι πραγματικές ταυτότητες των χρηστών θα συνδέονταν πλέον με τις δημοσιεύσεις τους. Αυτές οι τρεις φάσεις καλύπτουν ολόκληρο το φάσμα από την πλήρη ανωνυμία έως την πλήρη λογοδοσία. Οι Moore διαπίστωσαν ότι όσο αυξάνονταν οι περιορισμοί στην ανωνυμία, τόσο λιγότερα σχόλια δημοσιεύονταν. Αν και τα συνολικά σχόλια μειώθηκαν στη δεύτερη φάση, η γνωστική πολυπλοκότητα των σχολίων σε αυτή τη φάση αυξήθηκε έντονα. Αυτή η αύξηση στην γνωστική πολυπλοκότητα των σχολίων παρατηρήθηκε και στην τελική φάση, όταν χρησιμοποιούνταν προφίλ Facebook. Τα ευρήματα αυτά υποδεικνύουν ότι οι χρήστες είναι λιγότερο διατεθειμένοι να δημοσιεύσουν τις ειλικρινείς απόψεις τους όταν αισθάνονται ότι θα λογοδοτήσουν από τους ομοτίμους τους.

VIII‑C4 Μικρότερες Κοινότητες

Αντανακλώντας φυσικές δομές, η έμφαση σε μικρότερες κοινότητες μπορεί να ενθαρρύνει μεγαλύτερη αίσθηση λογοδοσίας μεταξύ διαδικτυακών ομοτίμων, μειώνοντας την προδιάθεση σε προκλητικό και πολωτικό περιεχόμενο. Σε σχολικό περιβάλλον, υπάρχει σύνδεση μεταξύ της αναλογίας μαθητών προς εκπαιδευτές και της ποιότητας του περιβάλλοντος της τάξης. Όταν μια τάξη έχει χαμηλότερη αναλογία μαθητών προς εκπαιδευτές, οι θετικές αλληλεπιδράσεις μεταξύ μαθητών και εκπαιδευτή τείνουν να αυξάνονται [Folmer‑Annevelink et al.(2010)]. Μια άλλη μελέτη διαπίστωσε ότι σε διαδικτυακές τάξεις, οι συζητήσεις που πραγματοποιούνται σε μικρές ομάδες οδήγησαν σε υψηλότερα ποσοστά συμμετοχής των μαθητών [Yang et al.(2022)]. Παρόλο που τα μέσα κοινωνικής δικτύωσης είναι μεροληπτικά υπέρ μεγάλων και πιο πολύπλοκων κοινωνικών δικτύων, μια εργασία που ανέλυσε έξι διαφορετικά φόρουμ στο dark web διαπίστωσε ότι, παρά το σχετικά μικρό μέγεθος αυτών των δικτύων και την γενική ανωνυμία της βάσης χρηστών, μικροί «κόμβοι‑ειδικοί» (influencer nodes) ήταν εξαιρετικά σημαντικοί στη διατήρηση ενεργού διαλόγου μέσα στο φόρουμ [Pete et al.(2020)]. Αυτό το εύρημα υποδηλώνει ότι ανεξάρτητα από το μέγεθος του κοινωνικού δικτύου, υπάρχει πάντα ένας αριθμός κρίσιμων κόμβων του ρόλου που φέρνουν κοντά τα πιο αδρανή και κοινωνικά μέλη μιας κοινότητας — ακόμη και όταν δεν υπάρχουν «νονείς» με ευρεία προβολή στο δίκτυο.

IX. Κενά και Μελλοντική Έρευνα

Οι περισσότερες προηγούμενες μελέτες για τις πλατφόρμες κοινωνικής δικτύωσης (ΠΚΔ) επικεντρώνονται στον αντίκτυπο στους χρήστες — όχι στον σχεδιασμό και τη δομή των ίδιων των πλατφορμών. Οι ΠΚΔ θεωρούνται συχνά ως παθητικό μέσο, μέσω του οποίου ένα άτομο ή ένας οργανισμός δημοσιεύει ή αλληλεπιδρά με μια κοινότητα. Οι συνέπειες όταν οι χρήστες πλήττονται αρνητικά δεν επιβαρύνουν την πλατφόρμα· έτσι, τα άτομα ή οι κοινότητες που πληγώνονται πρέπει να αναπτύξουν μηχανισμούς ανθεκτικότητας απέναντι στη διαδικτυακή παρενόχληση. Αυτό το πρόβλημα αναδεικνύεται από έρευνες που μελετούν τη σχέση μεταξύ ψυχικής υγείας και χρήσης κοινωνικών μέσων. Για να προωθηθεί θετική αλλαγή, προτείνουμε αρκετές κατευθύνσεις για μελλοντική έρευνα ώστε οι ΠΚΔ να βελτιωθούν με τη μείωση της διαδικτυακής τοξικότητας.

IX‑A. Δημογραφικά & Κίνητρα των Θυτών

Υπάρχει μεγάλο κενό στη βιβλιογραφία όσον αφορά τις δημογραφικές πληροφορίες και τα κίνητρα των διαδικτυακών επιθετικών. Εν μέρει, αυτό οφείλεται στη δυσκολία συλλογής τέτοιων δεδομένων. Ωστόσο, χωρίς αυτές τις κρίσιμες πληροφορίες, είναι δύσκολο να προχωρήσουμε από την τρέχουσα κατάσταση σε ενεργητικές στρατηγικές που θα αποθαρρύνουν τους χρήστες από την επιθετική επικοινωνία.

Με τόσο υψηλά ποσοστά θυματοποίησης, είτε ένας μικρός αριθμός χρηστών των ΠΚΔ αφιερώνει το μεγαλύτερο μέρος της διαδικτυακής του δραστηριότητας στη διάδοση τοξικότητας και διαδικτυακής παρενόχλησης, είτε υπάρχει σημαντική επικαλυπτόμενη ομάδα μεταξύ θυμάτων και θυτών. Μια προγενέστερη έρευνα υποστηρίζει την ιδέα ότι η διαδικτυακή παρενόχληση δημιουργεί έναν κύκλο όπου τα θύματα μπορούν να γίνουν δράστες [Garaigordobil(2015)]. Ωστόσο, αυτή η μελέτη έδειξε ότι μόνο το 15,5 % των χρηστών που υπέστησαν διαδικτυακό εκφοβισμό στη συνέχεια επιτέθηκαν και αυτοί με τη σειρά τους — και παρόλα αυτά, γνωρίζουμε ελάχιστα για τους χρήστες που παράγουν τοξικό περιεχόμενο σε ΠΚΔ.

IX‑B. Αλλαγή Εστίασης των Πλατφορμών Κοινωνικής Δικτύωσης

Η αντιμετώπιση της διαδικτυακής τοξικότητας πρέπει να επικεντρωθεί στις ίδιες τις ΠΚΔ. Η τοξικότητα, η παραπληροφόρηση και η πόλωση δεν αποτελούν μεμονωμένα λάθη χρηστών αλλά συμπτώματα ενός ανθυγιεινού συστήματος. Με τη διαδικτυακή παρενόχληση να πλήττει εκατομμύρια ανθρώπους, είναι σαφές ότι ο cyber‑bullying αποτελεί χαρακτηριστικό του σημερινού σχεδιασμού των ΠΚΔ — όχι απλώς τυχαία έκφανση ενός μικρού ποσοστού χρηστών [Vogels(2021)]. Έρευνες έχουν διαπιστώσει ότι τα πολωμένα περιεχόμενα εξαπλώνονται ταχύτερα από τα μη‑πολωμένα στις ΠΚΔ — υπογραμμίζοντας πως οι αλγόριθμοι των πλατφορμών μπορούν να ενθαρρύνουν τη δημιουργία τοξικού περιεχομένου [Vosoughi et al.(2018)]. Δεν αρκεί να προστίθενται νέα εργαλεία· χρειάζεται να αναρωτηθούμε τι στον υπάρχοντα σχεδιασμό των πλατφορμών ενθαρρύνει αυτές τις επιβλαβείς συμπεριφορές. Είναι απαραίτητο να κατανοήσουμε τι δίνει στους χρήστες το δικαίωμα ή την άνεση να στοχεύουν άλλους με αρνητικό τρόπο.

IX‑C. Αντισταθμισμοί Σχεδιαστικών Χαρακτηριστικών (Feature Trade‑Offs)

Η μελλοντική έρευνα πρέπει να αφιερώσει χρόνο στην κατανόηση των αντισταθμισμών που διαμορφώνουν τη συμπεριφορά των χρηστών. Για παράδειγμα, υπάρχει ήδη σαφές στοιχείο ότι οι άνθρωποι δημοσιεύουν διαφορετικά όταν χρησιμοποιούν ανώνυμους λογαριασμούς σε σύγκριση με όταν αισθάνονται ότι η ταυτότητά τους συνδέεται με τον λογαριασμό τους [Zhang and Kizilcec(2014)]. Ένας ακόμη, λιγότερο εξερευνημένος αντισταθμισμός είναι η επίδραση των bot‑based λογαριασμών. Παρότι υπάρχουν εκτεταμένες έρευνες για τη συμπεριφορά των bots, δεν έχουν γίνει μελέτες που να εξετάζουν πώς αλλάζει το τοξικό περιεχόμενο όταν οι χρήστες αλληλεπιδρούν με bots. Υποστηρίζουμε ότι πιθανώς υπάρχουν πολλοί ακόμη αντισταθμισμοί που δεν έχουν ακόμη εντοπιστεί.

IX‑D. Αλγόριθμοι Σύστασης (Recommendation Algorithms)

Η έρευνα για τα συστήματα σύστασης πλατφορμών κοινωνικής δικτύωσης αποτελεί σημαντικό μέρος της ανάλυσης των μέσων κοινωνικής δικτύωσης. Τα περισσότερα από αυτά τα συστήματα στηρίζονται σε δίκτυα φίλων και μοντέλα θεμάτων (topic modeling) για να κατανοήσουν πώς να αυξήσουν την εμπλοκή των χρηστών [Chen et al.(2013)]. Ωστόσο, ένα κοινό πρόβλημα με αυτούς τους αλγορίθμους είναι ότι έχουν τάση να δημιουργούν φυσαλίδες φίλτρου. Ενώ η πλειονότητα των ερευνών εστιάζει στα ενδιαφέροντα των χρηστών, δεν έχουν διερευνηθεί σε μεγάλο βαθμό πιο αφηρημένοι τρόποι σύστασης — όπως το να χτίζει κανείς κοινωνικά δίκτυα βάσει προσωπικότητας, τρόπου συνομιλίας ή άλλων ιδιότυπων χαρακτηριστικών.

Αν και πρόσφατες μελέτες αρχίζουν να εξερευνούν πιο αφηρημένα συστήματα σύστασης, όπως συστήματα βασισμένα στην προσωπικότητα [Dhelim et al.(2022), Tkalčič and Chen(2012)], και υπάρχουν ερευνητικές προσπάθειες για να συνεχιστούν οι αλγόριθμοι βασισμένοι σε θέματα που δεν οδηγούν σε φυσαλίδες φίλτρου [Gao et al.(2023), Nguyen et al.(2014), Wang et al.(2022)] — υπάρχει ακόμη αρκετός χώρος για να αμφισβητηθούν οι θεμελιώδεις αρχές που οδήγησαν στη δημιουργία τους.

IX‑E. Ανάγκη για Διεπιστημονική Προσέγγιση

Η διαδικτυακή τοξικότητα αγγίζει πολλά επιστημονικά πεδία, και επομένως είναι επιτακτική η ανάγκη συνεργασίας μεταξύ επιστημόνων από διαφορετικούς τομείς για τη δημιουργία πιο ολιστικών λύσεων. Αν και ο σχεδιασμός των ΠΚΔ θεωρείται κυρίως αντικείμενο της παραδοσιακής μηχανικής λογισμικού, είναι αναγκαία η συμμετοχή κοινωνιολόγων, ψυχολόγων, πολιτικών επιστημόνων και επιστημόνων δεδομένων ώστε να αντιμετωπιστεί συνολικά το φαινόμενο της τοξικότητας. Μια τέτοια συνεργασία θα μπορούσε να οδηγήσει σε πιο αποτελεσματικά μέσα καταπολέμησης των πολλαπλών παραγόντων που συμβάλλουν στην τοξικότητα.

IX‑F. Εικονική έναντι Φυσικής Αλληλεπίδρασης

Στον πυρήνα του προβλήματος βρίσκεται το γεγονός ότι οι διαδικτυακοί χώροι εξελίχθηκαν τόσο ραγδαία ώστε οι κοινωνικοί κανόνες δεν πρόλαβαν να ακολουθήσουν. Καθώς οι ΠΚΔ συνεχίζουν να εισάγουν καινοτόμα χαρακτηριστικά με βάση τις τελευταίες τεχνολογίες, καθίσταται όλο και πιο σημαντικό να κατανοήσουμε τα βασικά στοιχεία που κάνουν τις φυσικές κοινότητες λειτουργικές και να μεταφέρουμε τις θετικές πτυχές αυτών των αλληλεπιδράσεων στους εικονικούς χώρους.

X. Συμπεράσματα

Το σημερινό διαδικτυακό περιβάλλον δεν παρέχει επαρκή κίνητρα στις ΠΚΔ ώστε να απομακρυνθούν από τη λογική της αποκλειστικής εμπορευματοποίησης. Μέχρι να σχεδιαστούν πλατφόρμες με πρόθεση τη δημιουργία ασφαλών χώρων για διαδικτυακές κοινότητες, ο διαδικτυακός εκφοβισμός και άλλες μορφές τοξικότητας θα συνεχίσουν να εδραιώνονται.

Η παρούσα εργασία προσφέρει τέσσερις βασικές συνεισφορές:

- Συστηματοποίηση της υπάρχουσας γνώσης για την τοξικότητα,

- Καθορισμό ενός επίσημου ορισμού της τοξικότητας,

- Ανάδειξη κενών στη σχετική επιστημονική βιβλιογραφία,

- Πρόταση νέων ερευνητικών κατευθύνσεων για τη βελτίωση των ΠΚΔ.

Αν θέλεις, μπορώ να ετοιμάσω και περίληψη ή σύνοψη για χρήση σε ερευνητική εργασία ή παρουσίαση.

References

- [1]

- [Abro et al.(2020)]Sindhu Abro, Sarang Shaikh, Zahid Hussain Khand, Ali Zafar, Sajid Khan, and Ghulam Mujtaba. 2020.Automatic hate speech detection using machine learning: A comparative study.International Journal of Advanced Computer Science and Applications (2020).

- [Akuma et al.(2022)]Stephen Akuma, Tyosar Lubem, and Isaac Terngu Adom. 2022.Comparing Bag of Words and TF-IDF with different models for hate speech detection from live tweets.International Journal of Information Technology 14, 7 (2022), 3629–3635.

- [Alba and Frenkel(2019)]Davey Alba and Sheera Frenkel. 2019.Russia tests new disinformation tactics in Africa to expand influence.

- [Allcott et al.(2019)]Hunt Allcott, Matthew Gentzkow, and Chuan Yu. 2019.Trends in the diffusion of misinformation on social media.Research & Politics (2019).

- [Almerekhi et al.(2020)]Hind Almerekhi, Haewoon Kwak, Joni Salminen, and Bernard J Jansen. 2020.Are these comments triggering? predicting triggers of toxicity in online discussions. In Proceedings of the web conference 2020. 3033–3040.

- [Aridor et al.(2020)]Guy Aridor, Duarte Goncalves, and Shan Sikdar. 2020.Deconstructing the filter bubble: User decision-making and recommender systems. In Proceedings of the 14th ACM conference on recommender systems. 82–91.

- [Au et al.(2022)]Cheuk Hang Au, Kevin KW Ho, and Dickson KW Chiu. 2022.The role of online misinformation and fake news in ideological polarization: barriers, catalysts, and implications.Information systems frontiers (2022), 1–24.

- [Avalle et al.(2024)]Michele Avalle, Niccolò Di Marco, Gabriele Etta, Emanuele Sangiorgio, Shayan Alipour, Anita Bonetti, Lorenzo Alvisi, Antonio Scala, Andrea Baronchelli, Matteo Cinelli, et al. 2024.Persistent interaction patterns across social media platforms and over time.Nature 628, 8008 (2024), 582–589.

- [Aydemir(2020)]Ilayda Aydemir. 2020.SOCIAL MEDIA AUTOMATION EFFECTS ON BRAND REPUTATION.(2020).

- [Azzimonti and Fernandes(2022)]Marina Azzimonti and Marcos Fernandes. 2022.Social media networks, fake news, and polarization.European Journal of Political Economy (2022).

- [Balkus and Yan(2022)]Salvador V Balkus and Donghui Yan. 2022.Improving short text classification with augmented data using GPT-3.Natural Language Engineering (2022), 1–30.

- [Banjo(2019)]Shelly Banjo. 2019.Facebook, Twitter and the Digital Disinformation Mess.

- [Barlett(2015)]Christopher P Barlett. 2015.Anonymously hurting others online: The effect of anonymity on cyberbullying frequency.Psychology of Popular Media Culture 4, 2 (2015), 70.

- [Belanger(2021)]Alyssa Belanger. 2021.The Comparison of Effectiveness of Social Media Marketing by Brands and Influencers for Organic Cosmetics.(2021).

- [Bloch(2022)]Stefano Bloch. 2022.Aversive racism and community-instigated policing: The spatial politics of Nextdoor.Environment and Planning C: Politics and Space (2022).

- [Boyer(2021)]Dustin Boyer. 2021.Streaming bots are ruining careers of indie musicians.

- [Chen et al.(2013)]Song Chen, Samuel Owusu, and Lina Zhou. 2013.Social network based recommendation systems: A short survey. In International conference on social computing. IEEE.

- [Chitra and Musco(2020)]Uthsav Chitra and Christopher Musco. 2020.Analyzing the impact of filter bubbles on social network polarization. In International Conference on Web Search and Data Mining. 115–123.

- [Chu et al.(2024)]Minh Duc Chu, Aryan Karnati, Zihao He, and Kristina Lerman. 2024.Characterizing Online Eating Disorder Communities with Large Language Models.arXiv preprint arXiv:2401.09647 (2024).

- [Cinelli et al.(2021)]Matteo Cinelli, Andraž Pelicon, Igor Mozetič, Walter Quattrociocchi, Petra Kralj Novak, and Fabiana Zollo. 2021.Dynamics of online hate and misinformation.Scientific reports (2021).

- [Cosma et al.(2020)]Alina Cosma, Sophie D Walsh, Kayleigh L Chester, Mary Callaghan, Michal Molcho, Wendy Craig, and William Pickett. 2020.Bullying victimization: Time trends and the overlap between traditional and cyberbullying across countries in Europe and North America.International journal of public health 65 (2020), 75–85.

- [Croom(2011)]Adam M Croom. 2011.Slurs.Language Sciences (2011).

- [Dadvar et al.(2013)]Maral Dadvar, Dolf Trieschnigg, Roeland Ordelman, and Franciska De Jong. 2013.Improving cyberbullying detection with user context. In Advances in Information Retrieval: 35th European Conference on IR Research, ECIR 2013, Moscow, Russia, March 24-27, 2013. Proceedings 35. Springer, 693–696.

- [Dahlgren(2021)]Peter M Dahlgren. 2021.A critical review of filter bubbles and a comparison with selective exposure.Nordicom Review 42, 1 (2021), 15–33.

- [Dhelim et al.(2022)]Sahraoui Dhelim, Nyothiri Aung, Mohammed Amine Bouras, Huansheng Ning, and Erik Cambria. 2022.A survey on personality-aware recommendation systems.Artificial Intelligence Review (2022), 1–46.

- [Diaz(2021)]Jaclyn Diaz. 2021.Want to send a mean tweet? Twitter’s new feature wants you to think again.

- [Ding et al.(2020)]Yue Ding, Dongping Li, Xian Li, Jiale Xiao, Haiyan Zhang, and Yanhui Wang. 2020.Profiles of adolescent traditional and cyber bullying and victimization: The role of demographic, individual, family, school, and peer factors.Computers in Human Behavior 111 (2020), 106439.

- [Dutta et al.(2021)]Upasana Dutta, Rhett Hanscom, Jason Shuo Zhang, Richard Han, Tamara Lehman, Qin Lv, and Shivakant Mishra. 2021.Analyzing Twitter Users’ Behavior Before and After Contact by the Russia’s Internet Research Agency.Human-Computer Interaction (HCI) (2021).

- [Eady et al.(2023)]Gregory Eady, Tom Paskhalis, Jan Zilinsky, Richard Bonneau, Jonathan Nagler, and Joshua A Tucker. 2023.Exposure to the Russian Internet Research Agency foreign influence campaign on Twitter in the 2016 US election and its relationship to attitudes and voting behavior.Nature Communications (2023).

- [Ehrett(2016)]John S Ehrett. 2016.E-judiciaries: a model for community policing in cyberspace.Information & Communications Technology Law (2016).

- [Etta et al.(2024)]Gabriele Etta, Matteo Cinelli, Niccolo Di Marco, Michele Avalle, Alessandro Panconesi, and Walter Quattrociocchi. 2024.A Topology-Based Approach for Predicting Toxic Outcomes on Twitter and YouTube.IEEE Transactions on Network Science and Engineering (2024).

- [Facebook(2023)]Facebook. 2023.How to handle harassment and bullying on Facebook and Instagram.https://www.facebook.com/business/learn/lessons/handle-harassment-bullying.

- [Fan et al.(2021)]Hong Fan, Wu Du, Abdelghani Dahou, Ahmed A Ewees, Dalia Yousri, Mohamed Abd Elaziz, Ammar H Elsheikh, Laith Abualigah, and Mohammed AA Al-qaness. 2021.Social media toxicity classification using deep learning: real-world application UK brexit.Electronics 10, 11 (2021), 1332.

- [Fiske(2018)]Susan T Fiske. 2018.Controlling other people: The impact of power on stereotyping.In Social cognition. Routledge, 101–115.

- [Folmer-Annevelink et al.(2010)]Elvira Folmer-Annevelink, Simone Doolaard, Mayra Mascareño, and Roel J Bosker. 2010.Class size effects on the number and types of student-teacher interactions in primary classrooms.The Journal of Classroom Interaction (2010).

- [Gao et al.(2023)]Chongming Gao, Shiqi Wang, Shijun Li, Jiawei Chen, Xiangnan He, Wenqiang Lei, Biao Li, Yuan Zhang, and Peng Jiang. 2023.CIRS: Bursting filter bubbles by counterfactual interactive recommender system.ACM Transactions on Information Systems 42, 1 (2023), 1–27.

- [Garaigordobil(2015)]Maite Garaigordobil. 2015.Cyberbullying in adolescents and youth in the Basque Country: prevalence of cybervictims, cyberaggressors, and cyberobservers.Journal of Youth Studies (2015).

- [Goyal et al.(2022)]Nitesh Goyal, Ian D Kivlichan, Rachel Rosen, and Lucy Vasserman. 2022.Is your toxicity my toxicity? exploring the impact of rater identity on toxicity annotation.Human-Computer Interaction (2022).

- [Grossetti et al.(2020)]Quentin Grossetti, Cédric du Mouza, and Nicolas Travers. 2020.Community-based recommendations on Twitter: avoiding the filter bubble. In International Conference on Web Information Systems Engineering. Springer.

- [Hanbury([n. d.])]Mary Hanbury. [n. d.].Facebook overhauls group privacy settings and gives admins tools to scan rule-breaking posts in its war on toxic content.

- [He et al.(2023)]Xinlei He, Savvas Zannettou, Yun Shen, and Yang Zhang. 2023.You Only Prompt Once: On the Capabilities of Prompt Learning on Large Language Models to Tackle Toxic Content. In Symposium on Security and Privacy (SP). IEEE Computer Society.

- [Hosseini et al.(2017)]Hossein Hosseini, Sreeram Kannan, Baosen Zhang, and Radha Poovendran. 2017.Deceiving google’s perspective api built for detecting toxic comments.arXiv:1702.08138 (2017).

- [Interian et al.(2023)]Ruben Interian, Ruslán G. Marzo, Isela Mendoza, and Celso C Ribeiro. 2023.Network polarization, filter bubbles, and echo chambers: an annotated review of measures and reduction methods.International Transactions in Operational Research (2023).

- [Jain et al.(2018)]Edwin Jain, Stephan Brown, Jeffery Chen, Erin Neaton, Mohammad Baidas, Ziqian Dong, Huanying Gu, and Nabi Sertac Artan. 2018.Adversarial Text Generation for Google’s Perspective API. In International Conference on Computational Science and Computational Intelligence (CSCI). IEEE.

- [Jhaver et al.(2023)]Shagun Jhaver, Alice Qian Zhang, Quan Ze Chen, Nikhila Natarajan, Ruotong Wang, and Amy X Zhang. 2023.Personalizing content moderation on social media: User perspectives on moderation choices, interface design, and labor.Proceedings of the ACM on Human-Computer Interaction 7, CSCW2 (2023), 1–33.

- [Joachims(1998)]Thorsten Joachims. 1998.Text categorization with support vector machines: Learning with many relevant features. In European conference on machine learning. Springer.

- [Keijzer and Mäs(2022)]Marijn A Keijzer and Michael Mäs. 2022.The complex link between filter bubbles and opinion polarization.Data Science 5, 2 (2022), 139–166.

- [Kim et al.(2021)]Jin Woo Kim, Andrew Guess, Brendan Nyhan, and Jason Reifler. 2021.The distorting prism of social media: How self-selection and exposure to incivility fuel online comment toxicity.Journal of Communication (2021).

- [Klein and O’Brien(2018)]Nadav Klein and Ed O’Brien. 2018.People use less information than they think to make up their minds.National Academy of Sciences (2018).

- [Kubin and von Sikorski(2021)]Emily Kubin and Christian von Sikorski. 2021.The role of (social) media in political polarization: a systematic review.Annals of the International Communication Association (2021).

- [Kumar et al.(2021)]Deepak Kumar, Patrick Gage Kelley, Sunny Consolvo, Joshua Mason, Elie Bursztein, Zakir Durumeric, Kurt Thomas, and Michael Bailey. 2021.Designing toxic content classification for a diversity of perspectives. In Seventeenth Symposium on Usable Privacy and Security (SOUPS 2021). 299–318.

- [Kurwa(2019)]Rahim Kurwa. 2019.Building the digitally gated community: The case of Nextdoor.Surveillance & Society (2019).

- [Lakshmanan(2022)]Laks VS Lakshmanan. 2022.On a quest for combating filter bubbles and misinformation. In International Conference on Management of Data.

- [Li et al.(2024)]Lingyao Li, Lizhou Fan, Shubham Atreja, and Libby Hemphill. 2024.“HOT” ChatGPT: The promise of ChatGPT in detecting and discriminating hateful, offensive, and toxic comments on social media.ACM Transactions on the Web (2024).

- [Madhyastha et al.(2023)]Pranava Madhyastha, Antigoni Founta, and Lucia Specia. 2023.A study towards contextual understanding of toxicity in online conversations.Natural Language Engineering 29, 6 (2023), 1538–1560.https://doi.org/10.1017/S1351324923000414

- [Mall et al.(2020)]Raghvendra Mall, Mridul Nagpal, Joni Salminen, Hind Almerekhi, Soon-Gyo Jung, and Bernard J Jansen. 2020.Four types of toxic people: characterizing online users’ toxicity over time. In Nordic Conference on Human-Computer Interaction: Shaping Experiences, Shaping Society.

- [Moore et al.(2021)]Alfred Moore, Rolf Fredheim, Dominik Wyss, and Simon Beste. 2021.Deliberation and identity rules: The effect of anonymity, pseudonyms and real-name requirements on the cognitive complexity of online news comments.Political Studies (2021).

- [Muneer and Fati(2020)]Amgad Muneer and Suliman Mohamed Fati. 2020.A comparative analysis of machine learning techniques for cyberbullying detection on Twitter.Future Internet (2020).

- [Nechushtai and Lewis(2019)]Efrat Nechushtai and Seth C Lewis. 2019.What kind of news gatekeepers do we want machines to be? Filter bubbles, fragmentation, and the normative dimensions of algorithmic recommendations.Computers in human behavior 90 (2019), 298–307.

- [Nelimarkka et al.(2018)]Matti Nelimarkka, Salla-Maaria Laaksonen, and Bryan Semaan. 2018.Social media is polarized, social media is polarized: towards a new design agenda for mitigating polarization. In Designing Interactive Systems Conference.

- [Nguyen et al.(2014)]Tien T Nguyen, Pik-Mai Hui, F Maxwell Harper, Loren Terveen, and Joseph A Konstan. 2014.Exploring the filter bubble: the effect of using recommender systems on content diversity. In Proceedings of the 23rd international conference on World wide web. 677–686.

- [Pascual-Ferrá et al.(2021)]Paola Pascual-Ferrá, Neil Alperstein, Daniel J Barnett, and Rajiv N Rimal. 2021.Toxicity and verbal aggression on social media: Polarized discourse on wearing face masks during the COVID-19 pandemic.Big Data & Society 8, 1 (2021), 20539517211023533.

- [Patchin and Hinduja(2011)]Justin W Patchin and Sameer Hinduja. 2011.Traditional and nontraditional bullying among youth: A test of general strain theory.Youth & Society 43, 2 (2011), 727–751.

- [Pavlopoulos et al.(2021)]John Pavlopoulos, Jeffrey Sorensen, Léo Laugier, and Ion Androutsopoulos. 2021.SemEval-2021 task 5: Toxic spans detection. In international workshop on semantic evaluation.

- [Payne(2017)]Will Payne. 2017.Welcome to the polygon: Contested digital neighborhoods and spatialized segregation on Nextdoor.Computational Culture (2017).

- [Perrin(2015)]Andrew Perrin. 2015.Social media usage.Pew research center (2015).

- [Perspective API(2021a)]Perspective API. 2021a.Case studies.https://perspectiveapi.com/case-studies/.

- [Perspective API(2021b)]Perspective API. 2021b.Using machine learning to reduce toxicity online.https://perspectiveapi.com/.

- [Pete et al.(2020)]Ildiko Pete, Jack Hughes, Yi Ting Chua, and Maria Bada. 2020.A social network analysis and comparison of six dark web forums. In European symposium on security and privacy workshops. IEEE.

- [Pichel et al.(2021)]Rafael Pichel, Mairéad Foody, James O’Higgins Norman, Sandra Feijóo, Jesús Varela, and Antonio Rial. 2021.Bullying, cyberbullying and the overlap: What does age have to do with it?Sustainability 13, 15 (2021), 8527.

- [Pidikiti et al.(2020)]Srihaasa Pidikiti, Jason Shuo Zhang, Richard Han, Tamara Lehman, Qin Lv, and Shivakant Mishra. 2020.Understanding how readers determine the legitimacy of online news articles in the era of fake news. In International Conference on Advances in Social Networks Analysis and Mining (ASONAM). IEEE.

- [Pidikiti et al.(2022)]Srihaasa Pidikiti, Jason Shuo Zhang, Richard Han, Tamara Silbergleit Lehman, Qin Lv, and Shivakant Mishra. 2022.Understanding How Readers Determine the Legitimacy of Online Medical News Articles in the Era of Fake News.In Disease Control Through Social Network Surveillance. Springer.

- [Rasmussen et al.(2024)]Stig Hebbelstrup Rye Rasmussen, Alexander Bor, Mathias Osmundsen, and Michael Bang Petersen. 2024.‘Super-unsupervised’classification for labelling text: online political hostility as an illustration.British Journal of Political Science 54, 1 (2024), 179–200.

- [Recuero(2024)]Raquel Recuero. 2024.The Platformization of Violence: Toward a Concept of Discursive Toxicity on Social Media.Social Media+ Society 10, 1 (2024), 20563051231224264.

- [Reddit(2023)]Reddit. 2023.Content policy.https://www.redditinc.com/policies/content-policy.

- [Rhodes(2022)]Samuel C Rhodes. 2022.Filter bubbles, echo chambers, and fake news: how social media conditions individuals to be less critical of political misinformation.Political Communication (2022).

- [Rupapara et al.(2021)]Vaibhav Rupapara, Furqan Rustam, Hina Fatima Shahzad, Arif Mehmood, Imran Ashraf, and Gyu Sang Choi. 2021.Impact of SMOTE on imbalanced text features for toxic comments classification using RVVC model.IEEE Access 9 (2021), 78621–78634.

- [Salminen et al.(2020a)]Joni Salminen, Maximilian Hopf, Shammur A Chowdhury, Soon-gyo Jung, Hind Almerekhi, and Bernard J Jansen. 2020a.Developing an online hate classifier for multiple social media platforms.Human-centric Computing and Information Sciences (2020).

- [Salminen et al.(2020b)]Joni Salminen, Sercan Sengün, Juan Corporan, Soon-gyo Jung, and Bernard J Jansen. 2020b.Topic-driven toxicity: Exploring the relationship between online toxicity and news topics.PloS one 15, 2 (2020), e0228723.

- [Sap et al.(2021)]Maarten Sap, Swabha Swayamdipta, Laura Vianna, Xuhui Zhou, Yejin Choi, and Noah A Smith. 2021.Annotators with attitudes: How annotator beliefs and identities bias toxic language detection.arXiv preprint arXiv:2111.07997 (2021).

- [Saveski et al.(2021)]Martin Saveski, Brandon Roy, and Deb Roy. 2021.The structure of toxic conversations on Twitter. In Proceedings of the web conference 2021. 1086–1097.

- [Seering(2020)]Joseph Seering. 2020.Reconsidering community self-moderation: the role of research in supporting community-based models for online content moderation.ACM on Human-Computer Interaction 4 (2020), 107.

- [Shao et al.(2018)]Chengcheng Shao, Giovanni Luca Ciampaglia, Onur Varol, Kai-Cheng Yang, Alessandro Flammini, and Filippo Menczer. 2018.The spread of low-credibility content by social bots.Nature communications 9, 1 (2018), 1–9.

- [Shcherbakova and Nikiforchuk(2022)]Olena Shcherbakova and Svitlana Nikiforchuk. 2022.Social media and filter bubbles.Scientific Journal of Polonia University 54, 5 (2022), 81–88.

- [Sheth et al.(2022)]Amit Sheth, Valerie L Shalin, and Ugur Kursuncu. 2022.Defining and detecting toxicity on social media: context and knowledge are key.Neurocomputing (2022).

- [Simchon et al.(2022)]Almog Simchon, William J Brady, and Jay J Van Bavel. 2022.Troll and divide: the language of online polarization.PNAS nexus 1, 1 (2022), pgac019.

- [Spohr(2017)]Dominic Spohr. 2017.Fake news and ideological polarization: Filter bubbles and selective exposure on social media.Business information review 34, 3 (2017), 150–160.

- [Sun et al.(2019)]Chi Sun, Xipeng Qiu, Yige Xu, and Xuanjing Huang. 2019.How to fine-tune bert for text classification?. In Chinese computational linguistics: 18th China national conference, CCL 2019, Kunming, China, October 18–20, 2019, proceedings 18. Springer, 194–206.

- [Tkalčič and Chen(2012)]Marko Tkalčič and Li Chen. 2012.Personality and recommender systems.In Recommender systems handbook. Springer, 757–787.

- [Tomlein et al.(2021)]Matus Tomlein, Branislav Pecher, Jakub Simko, Ivan Srba, Robert Moro, Elena Stefancova, Michal Kompan, Andrea Hrckova, Juraj Podrouzek, and Maria Bielikova. 2021.An audit of misinformation filter bubbles on YouTube: Bubble bursting and recent behavior changes. In Conference on Recommender Systems.

- [Twitter(2023a)]Twitter. 2023a.How twitter handles abusive behavior.https://help.twitter.com/en/rules-and-policies/abusive-behavior.

- [Twitter(2023b)]Twitter. 2023b.Our range of enforcement options for violations.https://help.twitter.com/en/rules-and-policies/enforcement-options.

- [Vaidya et al.(2024)]Aatman Vaidya, Seema Nagar, and Amit A Nanavati. 2024.Analysing the Spread of Toxicity on Twitter. In Joint International Conference on Data Science & Management of Data. 118–126.

- [Varanasi(2022)]Lakshmi Varanasi. 2022.Twitter bots appear to be be in line with the company’s estimate of below 5%.

- [Vasconcellos et al.(2023)]Paulo Henrique Santos Vasconcellos, Pedro Diógenes de Almeida Lara, and Humberto Torres Marques-Neto. 2023.Analyzing polarization and toxicity on political debate in brazilian TikTok videos transcriptions. In Web Science Conference. 33–42.

- [Vogels(2021)]Emily A Vogels. 2021.The state of online harassment.Pew Research Center (2021).

- [Vosoughi et al.(2018)]Soroush Vosoughi, Deb Roy, and Sinan Aral. 2018.The spread of true and false news online.science 359, 6380 (2018), 1146–1151.

- [Vraga and Bode(2020)]Emily K Vraga and Leticia Bode. 2020.Defining misinformation and understanding its bounded nature: Using expertise and evidence for describing misinformation.Political Communication 37, 1 (2020), 136–144.

- [Wang et al.(2021b)]Le Wang, Meng Han, Xiaojuan Li, Ni Zhang, and Haodong Cheng. 2021b.Review of classification methods on unbalanced data sets.Ieee Access 9 (2021), 64606–64628.

- [Wang et al.(2022)]Wenjie Wang, Fuli Feng, Liqiang Nie, and Tat-Seng Chua. 2022.User-controllable recommendation against filter bubbles. In Proceedings of the 45th international ACM SIGIR conference on research and development in information retrieval. 1251–1261.